Les langues humaines sont difficiles à comprendre pour les machines, car elles impliquent de nombreux acronymes, différentes significations, sous-significations, règles grammaticales, contexte, argot et bien d'autres aspects.

Mais de nombreux processus et opérations métier exploitent les machines et nécessitent une interaction entre les machines et les humains.

Les scientifiques avaient donc besoin d'une technologie qui aiderait la machine à décoder les langages humains et à faciliter leur apprentissage par les machines.

C'est à ce moment-là que les algorithmes de traitement du langage naturel ou NLP ont vu le jour. Il a créé des programmes informatiques capables de comprendre différentes langues humaines, que les mots soient écrits ou parlés.

La PNL utilise différents algorithmes pour traiter les langages. Et avec l'introduction des algorithmes NLP, la technologie est devenue un élément crucial de Intelligence artificielle (IA) pour aider à rationaliser les données non structurées.

Dans cet article, je vais discuter de la PNL et de certains des algorithmes de PNL dont on parle le plus.

Commençons!

What Is NLP?

Le processus de langage naturel (PNL) est un domaine de l'informatique, de la linguistique et de l'intelligence artificielle qui traite de l'interaction entre le langage humain et les ordinateurs. Il aide les machines à programmer afin qu'elles puissent analyser et traiter de gros volumes de données associées aux langages naturels.

En d'autres termes, la PNL est une technologie ou un mécanisme moderne utilisé par les machines pour comprendre, analyser et interpréter le langage humain. Il donne aux machines la capacité de comprendre les textes et le langage parlé des humains. Avec la PNL, les machines peuvent effectuer la traduction, reconnaissance de la parole, la synthèse, la segmentation des sujets et de nombreuses autres tâches pour le compte des développeurs.

La meilleure partie est que la PNL effectue tout le travail et les tâches en temps réel en utilisant plusieurs algorithmes, ce qui la rend beaucoup plus efficace. C'est une de ces technologies qui mélange machine learning, apprentissage en profondeur et modèles statistiques avec modélisation basée sur des règles linguistiques computationnelles.

Les algorithmes NLP permettent aux ordinateurs de traiter le langage humain à travers des textes ou des données vocales et de décoder sa signification à diverses fins. La capacité d'interprétation des ordinateurs a tellement évolué que les machines peuvent même comprendre les sentiments humains et l'intention derrière un texte. La PNL peut également prédire les mots ou les phrases à venir qui viennent à l'esprit d'un utilisateur lorsqu'il écrit ou parle.

Cette technologie est présente depuis des décennies et, avec le temps, elle a été évaluée et a atteint une meilleure précision des processus. La PNL a ses racines liées au domaine de la linguistique et a même aidé les développeurs à créer des moteurs de recherche pour Internet. Au fur et à mesure que la technologie a progressé avec le temps, son utilisation de la PNL s'est étendue.

Aujourd'hui, la PNL trouve des applications dans un vaste éventail de domaines, de la finance, des moteurs de recherche et de l'intelligence économique aux soins de santé et à la robotique. De plus, la PNL a pénétré profondément dans les systèmes modernes ; il est utilisé pour de nombreuses applications populaires telles que le GPS à commande vocale, chatbots de service client, aide numérique, parole-texte fonctionnement, et bien d'autres encore.

How Does NLP Work?

La PNL est une technologie dynamique qui utilise différentes méthodologies pour traduire un langage humain complexe pour les machines. Il utilise principalement l'intelligence artificielle pour traiter et traduire des mots écrits ou parlés afin qu'ils puissent être compris par les ordinateurs.

Comme les humains ont un cerveau pour traiter toutes les entrées, les ordinateurs utilisent un programme spécialisé qui les aide à traiter l'entrée en une sortie compréhensible. La PNL fonctionne en deux phases lors de la conversion, où l'une est informatique et l'autre est le développement d'algorithmes.

Le traitement des données sert de première phase, où les données de texte d'entrée sont préparées et nettoyées afin que la machine puisse les analyser. Les données sont traitées de manière à souligner toutes les caractéristiques du texte d'entrée et à les rendre adaptées aux algorithmes informatiques. Fondamentalement, l'étape de traitement des données prépare les données sous une forme que la machine peut comprendre.

Les techniques qui interviennent dans cette phase sont :

- tokenization: Le texte d'entrée est séparé en petites formes afin qu'il soit adapté à la PNL pour travailler dessus.

- Suppression du mot d'arrêt: La technique de suppression des mots vides supprime tous les mots familiers du texte et les transforme en une forme qui conserve toutes les informations à un état minimal.

- Lemmatisation et radicalisation: La lemmatisation et la radicalisation entraînent une diminution des mots jusqu'à leur structure racine, de sorte qu'il est facile pour les machines de les traiter.

- Marquage des parties du discours: De cette manière, les mots d'entrée sont marqués en fonction de leur nom, adjectifs et verbes, puis ils sont traités.

Après que les données d'entrée ont traversé la première phase, ensuite, la machine développe un algorithme où elle peut enfin les traiter. Parmi tous les algorithmes NLP utilisés pour traiter les mots prétraités, les systèmes basés sur des règles et basés sur l'apprentissage automatique sont largement utilisés :

- Systèmes basés sur des règles : Ici, le système utilise des règles linguistiques pour le traitement final des mots. C'est un vieil algorithme qui est encore utilisé à grande échelle.

- Systèmes basés sur l'apprentissage automatique : Il s'agit d'un algorithme avancé combinant les réseaux de neurones, l'apprentissage en profondeur et l'apprentissage automatique pour décider de sa propre règle de traitement des mots. Puisqu'il utilise des méthodes statistiques, l'algorithme décide du traitement des mots en fonction des données d'apprentissage et apporte des modifications au fur et à mesure.

NLP Algorithms Categories

Les algorithmes NLP sont des algorithmes ou des instructions basés sur ML qui sont utilisés lors du traitement des langues naturelles. Ils s'intéressent au développement de protocoles et de modèles permettant à une machine d'interpréter les langages humains.

Les algorithmes NLP peuvent modifier leur forme en fonction de l'approche de l'IA et également des données d'entraînement avec lesquelles ils ont été alimentés. Le travail principal de ces algorithmes est d'utiliser différentes techniques pour transformer efficacement des entrées confuses ou non structurées en informations bien informées dont la machine peut apprendre.

En plus de toutes les techniques, les algorithmes NLP utilisent les principes du langage naturel pour rendre les entrées plus compréhensibles pour la machine. Ils sont chargés d'aider la machine à comprendre la valeur contextuelle d'une entrée donnée ; sinon, la machine ne pourra pas exécuter la demande.

Les algorithmes NLP sont séparés en trois catégories de base différentes, et les modèles d'IA choisissent l'une des catégories en fonction de l'approche du scientifique des données. Ces catégories sont :

# 1. Algorithmes symboliques

Les algorithmes symboliques constituent l'un des piliers des algorithmes NLP. Ceux-ci sont chargés d'analyser la signification de chaque texte d'entrée, puis de l'utiliser pour établir une relation entre différents concepts.

Les algorithmes symboliques exploitent les symboles pour représenter les connaissances ainsi que la relation entre les concepts. Étant donné que ces algorithmes utilisent la logique et attribuent des significations aux mots en fonction du contexte, vous pouvez obtenir une grande précision.

Les graphes de connaissances jouent également un rôle crucial dans la définition des concepts d'une langue d'entrée ainsi que la relation entre ces concepts. En raison de sa capacité à définir correctement les concepts et à comprendre facilement les contextes de mots, cet algorithme aide à construire XAI.

Cependant, les algorithmes symboliques sont difficiles à étendre un ensemble de règles en raison de diverses limitations.

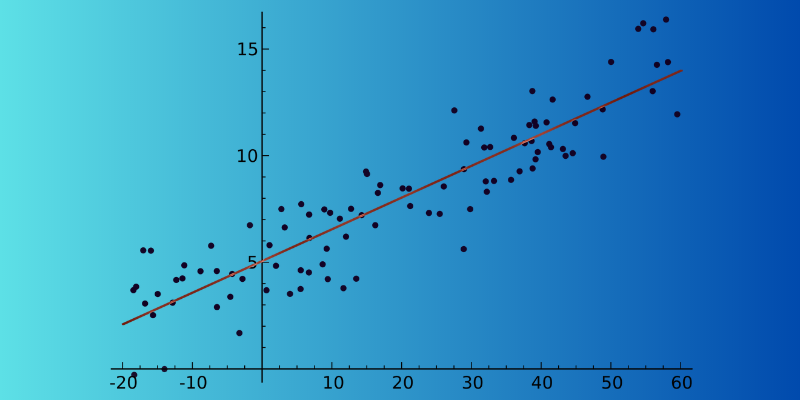

# 2. Algorithmes statistiques

Les algorithmes statistiques peuvent faciliter la tâche des machines en parcourant les textes, en comprenant chacun d'eux et en récupérant le sens. Il s'agit d'un algorithme PNL très efficace car il aide les machines à apprendre le langage humain en reconnaissant les modèles et les tendances dans le tableau des textes d'entrée. Cette analyse aide les machines à prédire quel mot est susceptible d'être écrit après le mot actuel en temps réel.

De la reconnaissance vocale, l'analyse des sentiments, et la traduction automatique en suggestion de texte, les algorithmes statistiques sont utilisés pour de nombreuses applications. La principale raison de son utilisation généralisée est qu'il peut fonctionner sur de grands ensembles de données.

De plus, des algorithmes statistiques peuvent détecter si deux phrases d'un paragraphe ont un sens similaire et laquelle utiliser. Cependant, le principal inconvénient de cet algorithme est qu'il dépend en partie d'une ingénierie de fonctionnalités complexes.

# 3. Algorithmes hybrides

Ce type d'algorithme NLP combine la puissance des algorithmes symboliques et statistiques pour produire un résultat efficace. En se concentrant sur les principaux avantages et fonctionnalités, il peut facilement annuler la faiblesse maximale de l'une ou l'autre approche, qui est essentielle pour une grande précision.

Il existe de nombreuses façons d'exploiter les deux approches :

- Symbolique soutenant l'apprentissage automatique

- Apprentissage automatique prenant en charge la symbolique

- Apprentissage symbolique et machine fonctionnant en parallèle

Les algorithmes symboliques peuvent prendre en charge l'apprentissage automatique en l'aidant à entraîner le modèle de manière à ce qu'il doive faire moins d'efforts pour apprendre le langage par lui-même. Bien que l'apprentissage automatique supporte les moyens symboliques, le modèle ML peut créer un ensemble de règles initial pour le symbolique et épargner au data scientist de le construire manuellement.

Cependant, lorsque l'apprentissage symbolique et automatique fonctionnent ensemble, cela donne de meilleurs résultats car il peut garantir que les modèles comprennent correctement un passage spécifique.

Best NLP Algorithms

Il existe de nombreux algorithmes NLP qui aident un ordinateur à imiter le langage humain pour la compréhension. Voici les meilleurs algorithmes NLP que vous pouvez utiliser :

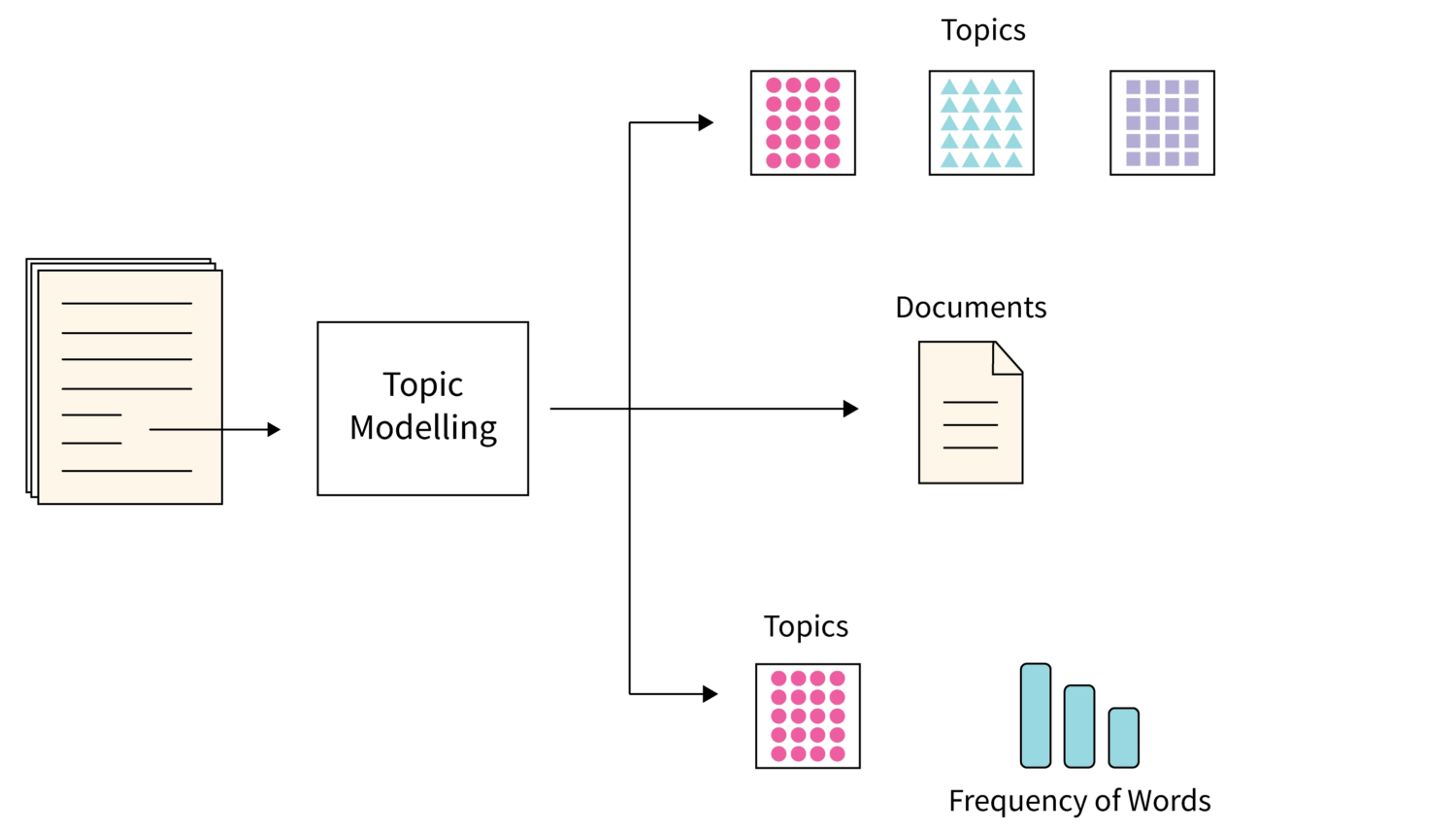

# 1. Modélisation de sujets

La modélisation de sujet est l'un de ces algorithmes qui utilisent des techniques statistiques de PNL pour trouver des thèmes ou des sujets principaux à partir d'un grand nombre de documents texte.

Fondamentalement, cela aide les machines à trouver le sujet qui peut être utilisé pour définir un ensemble de textes particulier. Comme chaque corpus de documents textuels contient de nombreux sujets, cet algorithme utilise toute technique appropriée pour découvrir chaque sujet en évaluant des ensembles particuliers du vocabulaire des mots.

L'allocation latente de Dirichlet est un choix populaire lorsqu'il s'agit d'utiliser la meilleure technique de modélisation de sujet. C'est un non surveillé Algorithme ML et aide à accumuler et à organiser des archives d'une grande quantité de données, ce qui n'est pas possible par une annotation humaine.

# 2. Synthèse de texte

Il s'agit d'une technique PNL très exigeante où l'algorithme résume un texte brièvement et de manière fluide. C'est un processus rapide car le résumé aide à extraire toutes les informations précieuses sans passer par chaque mot.

La synthèse peut se faire de deux manières :

- Résumé basé sur l'extraction : Cela amène la machine à extraire uniquement les principaux mots et phrases du document sans modifier l'original.

- Résumé basé sur l'abstraction : Dans ce processus, de nouveaux mots et expressions sont créés à partir du document texte, qui décrit toutes les informations et l'intention.

# 3. Analyse sentimental

C'est l'algorithme NLP qui aide une machine à comprendre le sens ou l'intention derrière un texte de l'utilisateur. Il est très populaire et utilisé dans différents modèles d'entreprise d'IA, car il aide les entreprises à comprendre ce que les clients pensent de leurs produits ou services.

En comprenant l'intention des données textuelles ou vocales d'un client sur différentes plates-formes, les modèles d'IA peuvent vous informer sur les sentiments d'un client et vous aider à les aborder en conséquence.

# 4. Extraction de mots clés

L'extraction de mots-clés est un autre algorithme PNL populaire qui aide à extraire un grand nombre de mots et de phrases ciblés à partir d'un vaste ensemble de données textuelles.

Il existe différents algorithmes d'extraction de mots clés disponibles qui incluent des noms populaires tels que TextRank, Term Frequency et RAKE. Certains algorithmes peuvent utiliser des mots supplémentaires, tandis que d'autres peuvent aider à extraire des mots clés en fonction du contenu d'un texte donné.

Chacun des algorithmes d'extraction de mots clés utilise ses propres méthodes théoriques et fondamentales. Il est avantageux pour de nombreuses organisations car il aide à stocker, rechercher et récupérer du contenu à partir d'un ensemble de données non structuré important.

# 5. Graphiques de connaissances

Lorsqu'il s'agit de choisir le meilleur algorithme NLP, beaucoup considèrent les algorithmes de graphes de connaissances. C'est une excellente technique qui utilise des triplets pour stocker des informations.

Cet algorithme est essentiellement un mélange de trois choses - sujet, prédicat et entité. Cependant, la création d'un graphe de connaissances ne se limite pas à une technique ; au lieu de cela, il nécessite plusieurs techniques de PNL pour être plus efficace et détaillé. L'approche par sujet est utilisée pour extraire des informations ordonnées à partir d'un tas de textes non structurés.

# 6. TF-IDF

TF-IDF est un algorithme statistique NLP qui est important pour évaluer l'importance d'un mot pour un document particulier appartenant à une collection massive. Cette technique implique la multiplication de valeurs distinctives, qui sont :

- Fréquence des mandats : La valeur de fréquence du terme vous donne le nombre total de fois qu'un mot apparaît dans un document particulier. Les mots vides obtiennent généralement une fréquence de terme élevée dans un document.

- Inverser la fréquence des documents : La fréquence inverse des documents, quant à elle, met en évidence les termes qui sont très spécifiques à un document ou des mots qui apparaissent moins dans tout un corpus de documents.

# 7. Nuage de mots

Words Cloud est un algorithme NLP unique qui implique des techniques de visualisation de données. Dans cet algorithme, les mots importants sont mis en surbrillance, puis ils sont affichés dans un tableau.

Les mots essentiels du document sont imprimés en gros caractères, tandis que les mots les moins importants sont affichés en petits caractères. Parfois, les choses les moins importantes ne sont même pas visibles sur la table.

Learning Resources

Outre les informations ci-dessus, si vous souhaitez en savoir plus sur le traitement du langage naturel (PNL), vous pouvez envisager les cours et les livres suivants.

# 1. Science des données : traitement du langage naturel en Python

Ce cours by Udemy est très bien noté par les apprenants et méticuleusement créé par Lazy Programmer Inc. Il enseigne tout sur les algorithmes NLP et NLP et vous apprend à écrire une analyse des sentiments. D'une durée totale de 11 heures et 52 minutes, ce cours vous donne accès à 88 conférences.

# 2. Traitement automatique du langage naturel : NLP avec transformateurs en Python

Avec ce cours populaire de Udemy, vous découvrirez non seulement la PNL avec des modèles de transformateurs, mais vous aurez également la possibilité de créer des modèles de transformateurs affinés. Ce cours vous donne une couverture complète de la PNL avec ses 11.5 heures de vidéo à la demande et 5 articles. De plus, vous découvrirez les techniques de création de vecteurs et le prétraitement des données textuelles pour la PNL.

# 3. Traitement du langage naturel avec transformateurs

Ce livre a été publié pour la première fois en 2017 et visait à aider les scientifiques des données et les codeurs à se familiariser avec la PNL. Une fois que vous aurez commencé à lire le livre, vous pourrez créer et optimiser des modèles de transformateurs pour de nombreuses tâches NLP. Vous apprendrez également comment vous pouvez utiliser les transformateurs pour l'apprentissage par transfert interlinguistique.

| Aperçu | Produit | Note | Tarif | |

|---|---|---|---|---|

|

Traitement du langage naturel avec transformateurs, édition révisée | $45.99 | Acheter sur Amazon |

# 4. Traitement pratique du langage naturel

À travers ce livre, les auteurs ont expliqué les tâches, les problèmes et les approches de solution pour la PNL. Ce livre enseigne également sur la mise en œuvre et l'évaluation de différentes applications NLP.

| Aperçu | Produit | Note | Tarif | |

|---|---|---|---|---|

|

Traitement pratique du langage naturel: un guide complet pour créer des systèmes PNL du monde réel | $62.09 | Acheter sur Amazon |

Conclusion

La PNL fait partie intégrante du monde de l'IA moderne qui aide les machines à comprendre les langages humains et à les interpréter. Les algorithmes NLP sont utiles pour diverses applications, des moteurs de recherche et de l'informatique à la finance, au marketing et au-delà.

Outre les détails ci-dessus, j'ai également répertorié certains des meilleurs Cours de PNL et des livres qui vous aideront à approfondir vos connaissances en PNL.

-

Amrita est rédactrice indépendante et rédactrice de contenu. Elle aide les marques à améliorer leur présence en ligne en créant un contenu impressionnant qui connecte et convertit. Elle a complété son baccalauréat en technologie (B.Tech) en génie aéronautique…. lire la suite