Si está interesado en la IA, este artículo sin duda le ayudará a profundizar en sus complejidades. Estoy aquí para guiarlo en su viaje hacia el ámbito de las plataformas LLMOps y brindarle claridad sobre las herramientas cruciales que se ofrecen para probar, mejorar e implementar LLM.

Las plataformas que aparecen en esta lista destacada desempeñan un papel fundamental a la hora de desbloquear todo el potencial de los modelos lingüísticos, presentando soluciones innovadoras para el desarrollo y la gestión.

Organizaciones reconocidas como Google, OpenAI y Microsoft aprovechan las plataformas LLMOps para garantizar pruebas exhaustivas, un refinamiento continuo y una implementación efectiva de sus modelos de lenguaje, lo que genera resultados confiables y precisos.

Reconociendo que LLMOps puede ser nuevo para muchos, comencemos por obtener una comprensión básica de LLMOps: su importancia, funciones y beneficios.

Con esta base, podemos proceder a nuestro objetivo principal: identificar las herramientas óptimas para nuestros lectores en función de sus requisitos específicos. La lista principal incluida en este artículo sirve como guía para lograr este objetivo.

¿Qué es LLMOps?

LLMOps significa Operaciones de modelo de lenguaje. Se trata de gestionar, implementar y mejorar modelos de lenguaje grandes como los que se utilizan en la IA. LLMOps implica herramientas y procesos para entrenar, probar y mantener estos modelos, garantizando que funcionen bien y se mantengan precisos a lo largo del tiempo.

Aunque los LLM son fáciles de crear prototipos, su uso en productos comerciales plantea desafíos. El ciclo de desarrollo de LLM incluye pasos complejos como la preparación de datos, el ajuste del modelo y la implementación, lo que requiere una experiencia fluida. trabajo en equipo. LLMOps cubre este ciclo, garantizando una experimentación, implementación y mejora fluidas.

Y finalmente, me gustaría que comprendiera qué es la plataforma LLMOps, ya que le brindará una claridad precisa y seguir este camino definitivamente le brindará un buen resultado después de leerlo.

La plataforma LLMOps fomenta la colaboración entre científicos e ingenieros de datos, lo que ayuda a la exploración iterativa de datos. Permite el trabajo conjunto en tiempo real, el seguimiento de experimentos, la gestión de modelos y la implementación controlada de LLM. LLMOps automatiza las operaciones, la sincronización y la supervisión durante todo el ciclo de vida del aprendizaje automático.

¿Cómo funciona LLMOps?

Las plataformas LLMOps simplifican todo el ciclo de vida de los modelos de lenguaje. Centralizan la preparación de datos, permiten la experimentación y permiten realizar ajustes para tareas específicas. Estas plataformas también facilitan una implementación fluida, un monitoreo continuo y una transición de versiones fluida.

Se promueve la colaboración, se minimizan los errores mediante la automatización y se respalda el refinamiento continuo. En esencia, LLMOps optimiza la gestión de modelos de lenguaje para diversas aplicaciones.

Beneficios de LLMOps

Las principales ventajas que considero importantes incluyen la eficiencia, la precisión y la escalabilidad. Aquí hay una versión elaborada de los beneficios que ofrece LLMOps:

- Eficiencia: Las plataformas LLMOps optimizan el ciclo completo de desarrollo, prueba e implementación del modelo de lenguaje, lo que genera ahorros de tiempo y esfuerzo.

- Colaboración: Estas plataformas fomentan una cooperación fluida entre científicos de datos, ingenieros y partes interesadas, promoviendo un trabajo en equipo eficaz.

- Precisión: Los LLMOps mantienen y mejoran la precisión del modelo a lo largo del tiempo monitoreando y refinando continuamente los modelos.

- Automatización: LLMOps automatiza varias tareas, incluido el preprocesamiento y el monitoreo de datos, lo que reduce la necesidad de intervención manual.

- Escalabilidad: Al ampliar eficazmente los modelos, las plataformas LLMOps pueden adaptarse fácilmente a mayores cargas de trabajo o demandas.

- Facilidad de implementación: Los LLMOps garantizan que los modelos se integren sin problemas en aplicaciones o sistemas, minimizando los desafíos relacionados con la implementación.

En esencia, los LLMOps mejoran la eficiencia, la precisión y la escalabilidad al tiempo que promueven la colaboración, la automatización y la implementación perfecta.

Ahora, avancemos a nuestra lista de plataformas. Esta lista es una guía de Geekflare, pero la decisión de elegir la mejor para ti, según tus requerimientos y necesidades, está en tus manos.

Dify

¿Está intrigado por los rápidos avances en tecnologías LLM como GPT-4 y entusiasmado con su potencial práctico? Dificar está diseñado para atenderle. Permite a los desarrolladores, e incluso a aquellos sin una sólida formación técnica, crear rápidamente aplicaciones valiosas utilizando modelos de lenguaje extensos. Estas aplicaciones no sólo son fáciles de usar; están preparados para una mejora continua.

Características principales:

- Plataforma LLMOps fácil de usar: Desarrolle aplicaciones de IA sin esfuerzo utilizando GPT-4 y adminístrelas visualmente.

- IA contextual con sus datos: Utilizar documentos, contenido web o Noción notas como contexto de IA. Dify maneja el preprocesamiento y más, ahorrándole tiempo de desarrollo.

- Libere el potencial de LLM: Dify garantiza un acceso perfecto al modelo, integración de contexto, control de costos y anotación de datos para una creación fluida de IA.

- Plantillas listas para usar: Elija entre plantillas de generación de diálogo y texto, listas para personalizar para sus aplicaciones específicas.

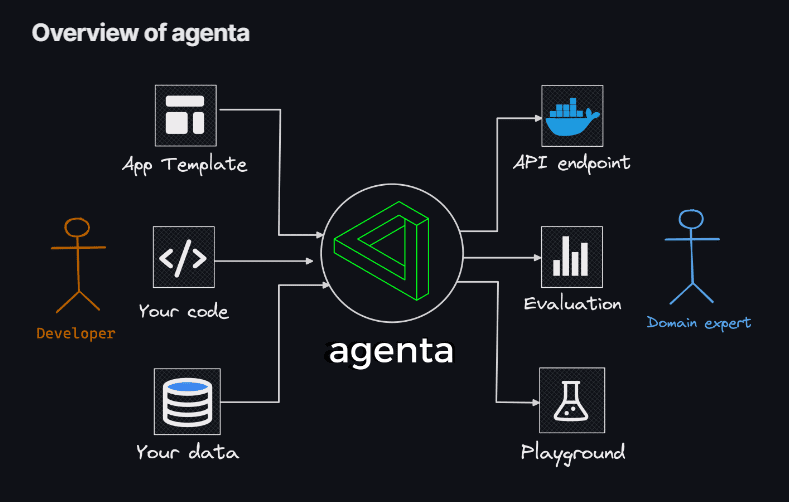

Agenta

Si está buscando la flexibilidad de utilizar la codificación para crear aplicaciones LLM, sin las limitaciones de modelos, bibliotecas o marcos, entonces agente es tu solución. Agenta surge como una plataforma de código abierto de extremo a extremo diseñada para agilizar el proceso de llevar a producción aplicaciones complejas de modelos de lenguaje grande (aplicaciones LLM).

Con Agenta, puede experimentar y versionar rápidamente indicaciones, parámetros y estrategias complejas. Esto abarca el aprendizaje en contexto con incorporaciones, agentes y lógica empresarial personalizada.

Características principales:

- Exploración de parámetros: Especifique los parámetros de su aplicación directamente dentro de su código y experimente con ellos sin esfuerzo a través de una plataforma web intuitiva.

- Evaluación del desempeño: Evalúe la eficacia de su aplicación en conjuntos de prueba utilizando una variedad de metodologías como coincidencia exacta, AI Critic, evaluación humana y más.

- Marco de prueba: cree conjuntos de pruebas sin esfuerzo utilizando la interfaz de usuario, ya sea cargando archivos CSV o conectándose sin problemas a sus datos a través de nuestra API.

- Entorno colaborativo: Fomente el trabajo en equipo compartiendo su aplicación con colaboradores e invitando a sus comentarios y opiniones.

- Despliegue sin esfuerzo: Inicie su aplicación como API con un solo clic, agilizando el proceso de implementación.

Además, Agenta fomenta la colaboración con expertos en el dominio para una ingeniería y evaluación rápidas. Otro punto destacado es la capacidad de Agenta para evaluar sistemáticamente sus aplicaciones LLM y facilitar la implementación de su aplicación con un solo clic.

Phoenix

Embárquese en un viaje instantáneo hacia los conocimientos de MLOps impulsados por Phoenix. Esta ingeniosa herramienta desbloquea a la perfección la observabilidad del rendimiento del modelo, la deriva y la calidad de los datos, todo sin la carga de configuraciones complejas.

Como biblioteca Python de vanguardia centrada en portátiles, Phoenix aprovecha la potencia de las incrustaciones para descubrir complejidades ocultas dentro de LLM, CV, NLP y modelos tabulares. Mejore sus modelos con las capacidades inigualables que Phoenix trae a la mesa.

Características principales:

- Investigación de deriva integrada: Sumérgete en las nubes de puntos UMAP durante instancias de distancia euclidiana sustancial y localiza grupos de deriva.

- Análisis de deriva y rendimiento mediante agrupación: Deconstruya sus datos en grupos con una desviación significativa o un rendimiento deficiente a través de HDBSCAN.

- Análisis de datos exploratorios impulsado por UMAP: sombree sus nubes de puntos UMAP según los atributos, la deriva y el rendimiento de su modelo, revelando segmentos problemáticos.

LangKit

Kit de idioma Se presenta como un conjunto de herramientas de código abierto para métricas de texto diseñado para monitorear modelos de lenguaje grandes de manera efectiva.

La fuerza impulsora detrás de la creación de LangKit surge de la comprensión de que transformar los modelos lingüísticos, incluidos los LLM, en producción implica varios riesgos. Las innumerables combinaciones potenciales de insumos, que conducen a resultados igualmente numerosos, plantean un desafío considerable.

Características principales:

- Análisis de inyección rápida: Calibre puntuaciones de similitud con ataques de inyección rápida reconocidos.

- Análisis de los sentimientos: Evaluar el sentimiento tono dentro del texto.

- Evaluación de la calidad del texto: Evaluar la legibilidad, la complejidad y las calificaciones.

- Detección de Jailbreak: Identifique puntuaciones de similitud con intentos de jailbreak conocidos.

- Análisis de toxicidad: Detecta niveles de toxicidad en el contenido proporcionado.

La naturaleza no estructurada del texto complica aún más las cosas en el ámbito de la observabilidad del ML, un desafío que merece resolución. Después de todo, la falta de conocimiento sobre el comportamiento de un modelo puede tener repercusiones importantes.

LiteLLM

Con LiteLLM, simplifique sus interacciones con varias API de LLM (Anthropic, Huggingface, Cohere, Azure OpenAI y más) utilizando un paquete liviano en formato OpenAI.

Este paquete agiliza el proceso de llamada a puntos finales API desde proveedores como OpenAI, Azure, Cohere y Anthropic. Traduce las entradas a los puntos finales de finalización e incorporación del proveedor relevante, lo que garantiza una salida uniforme. Siempre puedes acceder a las respuestas de texto en ['opciones'][0]['mensaje']['contenido'].

Características principales:

- Llamadas API LLM optimizadas: Simplifica la interacción con API de LLM como Anthropic, Cohere, Azure OpenAI, etc.

- Paquete ligero: Una solución compacta para llamar a puntos finales OpenAI, Azure, Cohere, Anthropic y API.

- Traducción de entrada: Gestiona la traducción de entradas a los puntos finales de finalización e incorporación del proveedor respectivo.

- Mapeo de excepciones: asigna excepciones comunes entre proveedores a tipos de excepciones de OpenAI para un manejo de errores estandarizado.

Además, el paquete incluye una función de mapeo de excepciones. Alinea las excepciones estándar de diferentes proveedores con los tipos de excepciones de OpenAI, lo que garantiza la coherencia en el manejo de errores.

LLM-App

Embárquese en el viaje de crear su exclusivo chatbot de IA de Discord, enriquecido con la destreza de responder preguntas, o sumérjase en la exploración de ideas de robots de IA similares. Todas estas cautivadoras funcionalidades convergen a través del Aplicación LLM.

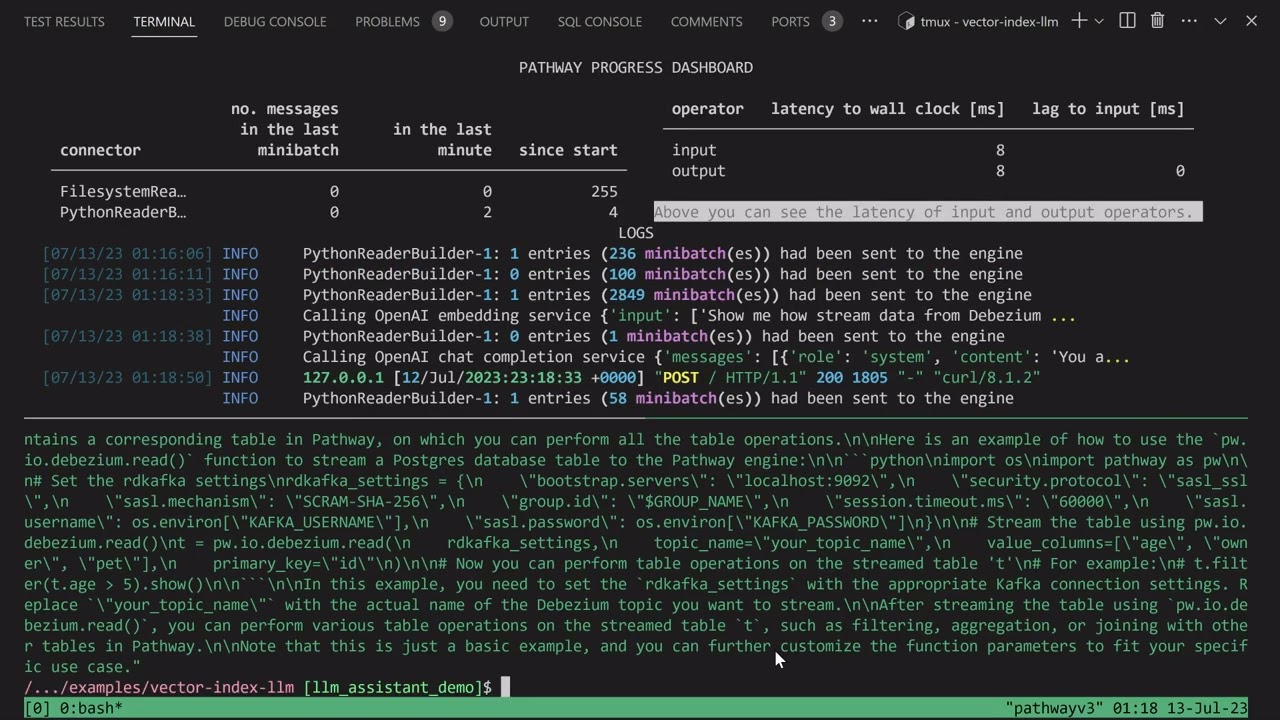

Les presento Pathways LLM-App, una biblioteca de Python meticulosamente diseñada para acelerar el desarrollo de aplicaciones de inteligencia artificial innovadoras.

Características principales:

- Diseñado para modelos de aprendizaje automático locales: La aplicación LLM está configurada para ejecutarse con modelos de aprendizaje automático locales, manteniéndose dentro de los límites de la organización.

- Manejo de datos en tiempo real: esta biblioteca administra hábilmente fuentes de datos en vivo, incluidas fuentes de noticias, API y flujos de datos de Kafka, con permisos de usuario y seguridad sólida.

- Sesiones de usuario fluidas: El proceso de creación de consultas de la biblioteca maneja de manera eficiente las sesiones de los usuarios, lo que garantiza interacciones fluidas.

Este activo excepcional le permite ofrecer respuestas instantáneas que reflejan las interacciones humanas al abordar las consultas de los usuarios. Logra esta notable hazaña al aprovechar de manera efectiva los conocimientos más recientes ocultos en sus fuentes de datos.

LLMFlows

LLMFlujos surge como un marco diseñado para simplificar, aclarar y aportar transparencia al desarrollo de aplicaciones de modelo de lenguaje grande (LLM), como chatbots, sistemas de respuesta a preguntas y agentes.

La complejidad puede amplificarse en escenarios del mundo real debido a las intrincadas relaciones entre las indicaciones y las llamadas de LLM.

Los creadores de LLMFlows imaginaron una API explícita que permitiera a los usuarios crear código limpio y comprensible. Esta API agiliza la creación de complejas interacciones LLM, garantizando un flujo fluido entre varios modelos.

Características principales:

- Configure sin problemas las clases de LLM, seleccionando meticulosamente modelos, parámetros y configuraciones específicos.

- Garantice interacciones sólidas de LLM con reintentos automáticos en caso de fallas en las llamadas al modelo, lo que garantiza la confiabilidad.

- Optimice el rendimiento y la eficiencia utilizando flujos asíncronos para la ejecución paralela de LLM cuando haya entradas disponibles.

- Incorpore funciones de manipulación de cadenas personalizadas directamente en los flujos, facilitando transformaciones de texto personalizadas más allá de las llamadas de LLM.

- Mantenga un control y una supervisión completos sobre las aplicaciones impulsadas por LLM con devoluciones de llamadas, ofreciendo monitoreo y visibilidad integrales de los procesos de ejecución.

Las clases de LLMFlows brindan a los usuarios una autoridad desenfrenada sin indicaciones ocultas ni llamadas de LLM.

Promptfoo

Acelere las evaluaciones mediante el almacenamiento en caché y las pruebas simultáneas utilizando rápidofoo. Proporciona una interfaz de línea de comandos (CLI) y una biblioteca, permite la evaluación de la calidad de los resultados de LLM.

Características principales:

- Fiabilidad probada en batalla: Promptfoo fue diseñado meticulosamente para evaluar y mejorar aplicaciones LLM que atienden a más de 10 millones de usuarios en un entorno de producción. Las herramientas proporcionadas son flexibles y adaptables a diversas configuraciones.

- Casos de prueba fáciles de usar: Defina evaluaciones sin codificar ni lidiar con cuadernos engorrosos. Un enfoque simple y declarativo agiliza el proceso.

- Flexibilidad de idioma: Ya sea que esté utilizando Python, Javascript o cualquier otro lenguaje, Promptfoo se adapta a sus preferencias.

Además, Promptfoo permite realizar pruebas sistemáticas de mensajes frente a casos de prueba predefinidos. Esto ayuda a evaluar la calidad e identificar regresiones al facilitar la comparación directa en paralelo de los resultados del LLM.

ZenML

Da la bienvenida a ZenML – una herramienta adaptable de código abierto diseñada para facilitar el mundo de los canales de aprendizaje automático para profesionales y organizaciones. Imagine tener una herramienta que le permita crear canales de aprendizaje automático listos para su uso en el mundo real, sin importar cuán complejo sea su proyecto.

ZenML separa los aspectos técnicos del código, lo que hace que sea más sencillo trabajar juntos para desarrolladores, científicos de datos, expertos en MLOps e ingenieros de ML. Esto significa que sus proyectos pueden pasar de la etapa de idea a estar listos para la acción más fácilmente.

Características principales:

- Para científicos de datos: Concéntrese en crear y probar modelos mientras ZenML prepara su código para su uso en el mundo real.

- Para expertos en infraestructura de MLOps: Configure, administre e implemente sistemas complejos rápidamente para que sus colegas puedan usarlos sin problemas.

- Para ingenieros de aprendizaje automático: Maneje cada paso de su proyecto de aprendizaje automático, de principio a fin, con la ayuda de ZenML. Esto significa menos transferencia de trabajo y más claridad en el recorrido de su organización.

ZenML está hecho para todos, ya sea un profesional o parte de una organización. Viene con una forma de escribir código diseñada para tareas de aprendizaje automático y funciona bien con cualquier servicio o herramienta en la nube que utilice. Además, te ayuda a gestionar tu proyecto en un solo lugar, para que no tengas que preocuparte por hacer malabarismos con diferentes cosas. Simplemente escriba su código una vez y úselo fácilmente en otros sistemas.

Pensamiento final

En esta apasionante odisea, ten siempre en cuenta que cada plataforma presenta una clave distinta capaz de desbloquear tus aspiraciones de IA. Tu selección tiene el poder de dar forma a tu camino, ¡así que elige sabiamente!

También puede explorar algunos Herramientas de IA para desarrolladores para crear aplicaciones más rápido.

-

Rishav se graduó en ciencias de la computación e ingeniería y completó su B.Tech en 2019. Su pasión por explorar el mundo de la tecnología lo ha llevado a dedicarse al desarrollo de contenido durante los últimos años. Para Rishav, la tecnología no es solo… LEER MÁS

-

Narendra Mohan Mittal es estratega senior de marca digital y editor de contenido con más de 12 años de experiencia versátil. Tiene un M-Tech (Medallista de oro) y B-Tech (Medallista de oro) en Informática e Ingeniería.

... LEER MÁS