Wenn Sie sich für KI interessieren, wird Ihnen dieser Artikel sicherlich dabei helfen, tief in ihre Feinheiten einzutauchen. Ich bin hier, um Sie auf Ihrer Reise in die Welt der LLMOps-Plattformen zu begleiten und Ihnen Klarheit über die entscheidenden Tools zu verschaffen, die zum Testen, Verbessern und Bereitstellen von LLMs angeboten werden.

Die in dieser prominenten Liste vorgestellten Plattformen spielen eine entscheidende Rolle bei der Erschließung des vollen Potenzials von Sprachmodellen und bieten innovative Lösungen für Entwicklung und Management.

Angesehene Organisationen wie Google, OpenAI und Microsoft nutzen LLMOps-Plattformen, um gründliche Tests, kontinuierliche Verfeinerung und effektive Bereitstellung ihrer Sprachmodelle sicherzustellen, was zu zuverlässigen und präzisen Ergebnissen führt.

Da LLMOps für viele möglicherweise neu ist, beginnen wir damit, ein grundlegendes Verständnis von LLMOps zu erlangen: seine Bedeutung, Funktionen und Vorteile.

Auf dieser Grundlage können wir uns dann unserem Hauptziel widmen – der Identifizierung der optimalen Tools für unsere Leser basierend auf ihren spezifischen Anforderungen. Der in diesem Artikel eingebettete Prime-Listicle dient als Leitfaden zur Erreichung dieses Ziels.

Was ist LLMOps?

LLMOps steht für Language Model Operations. Es geht um die Verwaltung, Bereitstellung und Verbesserung großer Sprachmodelle, wie sie in der KI verwendet werden. LLMOps umfasst Tools und Prozesse zum Trainieren, Testen und Warten dieser Modelle, um sicherzustellen, dass sie gut funktionieren und im Laufe der Zeit genau bleiben.

Obwohl sich LLMs leicht als Prototypen herstellen lassen, ist ihre Verwendung in kommerziellen Produkten mit Herausforderungen verbunden. Der LLM-Entwicklungszyklus umfasst komplizierte Schritte wie Datenvorbereitung, Modelloptimierung und Bereitstellung, die eine nahtlose Umsetzung erfordern . LLMOps deckt diesen Zyklus ab und gewährleistet ein reibungsloses Experimentieren, Bereitstellen und Verbessern.

Und schließlich möchte ich, dass Sie verstehen, was die LLMOps-Plattform ist, da sie Ihnen genaue Klarheit verschafft und Sie nach der Lektüre auf jeden Fall ein gutes Ergebnis erzielen, wenn Sie diesen Weg weitergehen.

Die LLMOps-Plattform fördert die Zusammenarbeit zwischen Datenwissenschaftlern und -ingenieuren und unterstützt die iterative Datenexploration. Es ermöglicht Zusammenarbeit in Echtzeit, Experimentverfolgung, Modellverwaltung und kontrollierte LLM-Bereitstellung. LLMOps automatisiert Vorgänge, Synchronisierung und Überwachung über den gesamten ML-Lebenszyklus.

Wie funktioniert LLMOps?

LLMOps-Plattformen vereinfachen den gesamten Lebenszyklus von Sprachmodellen. Sie zentralisieren die Datenvorbereitung, ermöglichen Experimente und ermöglichen eine Feinabstimmung für bestimmte Aufgaben. Diese Plattformen ermöglichen außerdem eine reibungslose Bereitstellung, kontinuierliche Überwachung und einen nahtlosen Versionsübergang.

Die Zusammenarbeit wird gefördert, Fehler durch Automatisierung minimiert und die laufende Weiterentwicklung unterstützt. Im Wesentlichen optimiert LLMOps die Sprachmodellverwaltung für verschiedene Anwendungen.

Vorteile von LLMOps

Zu den Hauptvorteilen, die ich für wesentlich halte, gehören Effizienz, Genauigkeit und Skalierbarkeit. Hier ist eine ausführliche Version der Vorteile, die LLMOps bietet:

- Effizienz: LLMOps-Plattformen optimieren den gesamten Zyklus der Entwicklung, Prüfung und Bereitstellung von Sprachmodellen und führen so zu Zeit- und Aufwandseinsparungen.

- Zusammenarbeit: Diese Plattformen fördern die nahtlose Zusammenarbeit zwischen Datenwissenschaftlern, Ingenieuren und Stakeholdern und fördern so eine effektive Teamarbeit.

- Genauigkeit: LLMOps erhalten und verbessern die Modellgenauigkeit im Laufe der Zeit, indem sie die Modelle kontinuierlich überwachen und verfeinern.

- Automation: LLMOps automatisiert mehrere Aufgaben, einschließlich der Datenvorverarbeitung und -überwachung, und reduziert so den Bedarf an manuellen Eingriffen.

- Skalierbarkeit: Durch die effektive Skalierung von Modellen können LLMOps-Plattformen erhöhte Arbeitslasten oder Anforderungen problemlos bewältigen.

- Einfache Bereitstellung: LLMOps stellen sicher, dass Modelle reibungslos in Anwendungen oder Systeme integriert werden, wodurch Herausforderungen im Zusammenhang mit der Bereitstellung minimiert werden.

Im Wesentlichen verbessern LLMOps die Effizienz, Genauigkeit und Skalierbarkeit und fördern gleichzeitig die Zusammenarbeit, Automatisierung und nahtlose Bereitstellung.

Kommen wir nun zu unserer Liste der Plattformen. Bei dieser Liste handelt es sich um einen Leitfaden von Geekflare, aber die Entscheidung, basierend auf Ihren Anforderungen und Bedürfnissen die beste für Sie auszuwählen, liegt in Ihren Händen.

Dify

Sind Sie fasziniert von den rasanten Fortschritten bei LLM-Technologien wie GPT-4 und begeistert von ihrem praktischen Potenzial? Verändern ist auf Sie zugeschnitten. Es ermöglicht Entwicklern und sogar solchen ohne ausgeprägten technischen Hintergrund, mithilfe umfangreicher Sprachmodelle schnell wertvolle Anwendungen zu erstellen. Diese Anwendungen sind nicht nur benutzerfreundlich; Sie sind auf eine kontinuierliche Weiterentwicklung ausgelegt.

Hauptmerkmale

- Benutzerfreundliche LLMOps-Plattform: KI-Anwendungen mühelos mit GPT-4 entwickeln und visuell verwalten.

- Kontextuelle KI mit Ihren Daten: Nutzen Sie Dokumente, Webinhalte usw Notion Notizen als KI-Kontext. Dify übernimmt die Vorverarbeitung und mehr und spart Ihnen so Entwicklungszeit.

- Entfesseln Sie das Potenzial von LLM: Dify gewährleistet nahtlosen Modellzugriff, Kontexteinbettung, Kostenkontrolle und Datenanmerkung für eine reibungslose KI-Erstellung.

- Fertige Vorlagen: Wählen Sie aus Dialog- und Textgenerierungsvorlagen, die Sie an Ihre spezifischen Anwendungen anpassen können.

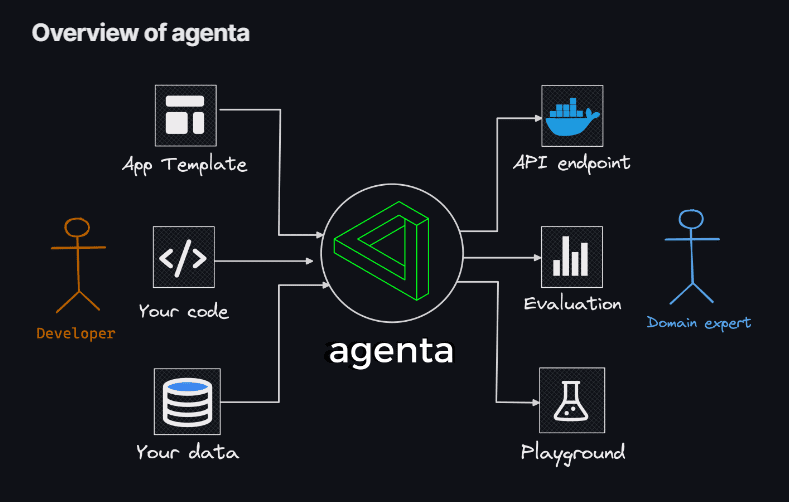

Agenta

Wenn Sie auf der Suche nach der Flexibilität sind, Codierung für die Erstellung von LLM-Apps zu verwenden, ohne den Einschränkungen von Modellen, Bibliotheken oder Frameworks unterliegen zu müssen, dann sind Sie genau richtig Agenta ist deine Lösung. Agenta ist eine Open-Source-End-to-End-Plattform, die darauf ausgelegt ist, den Prozess der Produktion komplexer Large Language Model-Anwendungen (LLM-Apps) zu rationalisieren.

Mit Agenta können Sie Eingabeaufforderungen, Parameter und komplizierte Strategien schnell experimentieren und versionieren. Dies umfasst kontextbezogenes Lernen mit Einbettungen, Agenten und benutzerdefinierter Geschäftslogik.

Hauptmerkmale

- Parametererkundung: Geben Sie die Parameter Ihrer Anwendung direkt in Ihrem Code an und experimentieren Sie mühelos über eine intuitive Webplattform damit.

- Leistungsbewertung: Bewerten Sie die Wirksamkeit Ihrer Anwendung anhand von Testsätzen mithilfe verschiedener Methoden wie exakter Übereinstimmung, KI-Kritik, menschlicher Bewertung und mehr.

- Test-Framework: Erstellen Sie mühelos Testsätze über die Benutzeroberfläche, sei es durch das Hochladen von CSVs oder die nahtlose Verbindung zu Ihren Daten über unsere API.

- Kollaborative Umgebung: Fördern Sie die Teamarbeit, indem Sie Ihre Bewerbung mit Mitarbeitern teilen und deren Feedback und Erkenntnisse einladen.

- Mühelose Bereitstellung: Starten Sie Ihre Anwendung mit einem einzigen Klick als API und optimieren Sie so den Bereitstellungsprozess.

Darüber hinaus fördert Agenta die Zusammenarbeit mit Fachexperten für eine zeitnahe Entwicklung und Bewertung. Ein weiteres Highlight ist die Fähigkeit von Agenta, Ihre LLM-Apps systematisch zu bewerten und die Bereitstellung Ihrer Anwendung mit einem Klick zu ermöglichen.

Phoenix

Begeben Sie sich auf eine sofortige Reise zu MLOps-Erkenntnissen, die von bereitgestellt werden Phoenix. Dieses geniale Tool ermöglicht nahtlos die Beobachtbarkeit von Modellleistung, Drift und Datenqualität, ohne den Aufwand komplizierter Konfigurationen.

Als avantgardistische, auf Notebooks ausgerichtete Python-Bibliothek nutzt Phoenix die Leistungsfähigkeit von Einbettungen, um verborgene Feinheiten in LLM-, CV-, NLP- und Tabellenmodellen aufzudecken. Werten Sie Ihre Modelle mit den unübertroffenen Funktionen von Phoenix auf.

Hauptmerkmale

- Eingebettete Driftuntersuchung: Tauchen Sie in UMAP-Punktwolken bei großer euklidischer Entfernung ein und lokalisieren Sie Driftcluster.

- Drift- und Leistungsanalyse mittels Clustering: Zerlegen Sie Ihre Daten mithilfe von HDBSCAN in Cluster mit erheblicher Abweichung oder unterdurchschnittlicher Leistung.

- UMAP-gestützte explorative Datenanalyse: Schattieren Sie Ihre UMAP-Punktwolken basierend auf den Attributen, der Drift und der Leistung Ihres Modells und decken Sie problematische Segmente auf.

LangKit

LangKit steht für ein Open-Source-Toolkit für Textmetriken, das zur effektiven Überwachung großer Sprachmodelle entwickelt wurde.

Die treibende Kraft hinter der Entwicklung von LangKit resultiert aus der Erkenntnis, dass die Umwandlung von Sprachmodellen, einschließlich LLMs, in die Produktion verschiedene Risiken mit sich bringt. Eine große Herausforderung stellen die unzähligen möglichen Input-Kombinationen dar, die zu ebenso zahlreichen Outputs führen.

Hauptmerkmale

- Schnelle Injektionsanalyse: Ähnlichkeitswerte mit erkannten schnellen Injektionsangriffen messen.

- Stimmungsanalyse: Bewerten Sie die Gefühl Ton innerhalb des Textes.

- Bewertung der Textqualität: Bewerten Sie Lesbarkeit, Komplexität und Notenwerte.

- Jailbreak-Erkennung: Identifizieren Sie Ähnlichkeitswerte mit bekannten Jailbreak-Versuchen.

- Toxizitätsanalyse: Erkennt den Grad der Toxizität im bereitgestellten Inhalt.

Die unstrukturierte Natur des Textes erschwert die Beobachtbarkeit von maschinellem Lernen zusätzlich – eine Herausforderung, die einer Lösung bedarf. Denn mangelnde Einsicht in das Verhalten eines Modells kann erhebliche Auswirkungen haben.

LiteLLM

Mit LiteLLMVereinfachen Sie Ihre Interaktionen mit verschiedenen LLM-APIs – Anthropic, Huggingface, Cohere, Azure OpenAI und mehr – mithilfe eines schlanken Pakets im OpenAI-Format.

Dieses Paket optimiert den Prozess des Aufrufs von API-Endpunkten von Anbietern wie OpenAI, Azure, Cohere und Anthropic. Es übersetzt Eingaben in die Vervollständigungs- und Einbettungsendpunkte des jeweiligen Anbieters und sorgt so für eine einheitliche Ausgabe. Sie können jederzeit auf Textantworten unter ['choices'][0]['message']['content'] zugreifen.

Hauptmerkmale

- Optimierter LLM-API-Aufruf: Vereinfacht die Interaktion mit LLM-APIs wie Anthropic, Cohere, Azure OpenAI usw.

- Leichtes Paket: Eine kompakte Lösung zum Aufrufen von OpenAI-, Azure-, Cohere-, Anthropic- und API-Endpunkten.

- Eingabeübersetzung: Verwaltet die Übersetzung von Eingaben an die Vervollständigungs- und Einbettungsendpunkte des jeweiligen Anbieters.

- Ausnahmezuordnung: Ordnet häufige Ausnahmen zwischen Anbietern OpenAI-Ausnahmetypen zu, um eine standardisierte Fehlerbehandlung zu ermöglichen.

Darüber hinaus enthält das Paket eine Ausnahmezuordnungsfunktion. Es gleicht Standardausnahmen verschiedener Anbieter mit OpenAI-Ausnahmetypen ab und gewährleistet so eine einheitliche Fehlerbehandlung.

LLM-App

Begeben Sie sich auf die Reise, Ihren einzigartigen Discord-KI-Chatbot zu erstellen, der durch die Fähigkeit, Fragen zu beantworten, bereichert wird, oder tauchen Sie ein in die Erkundung ähnlicher KI-Bot-Ideen. All diese faszinierenden Funktionalitäten vereinen sich in der LLM-App.

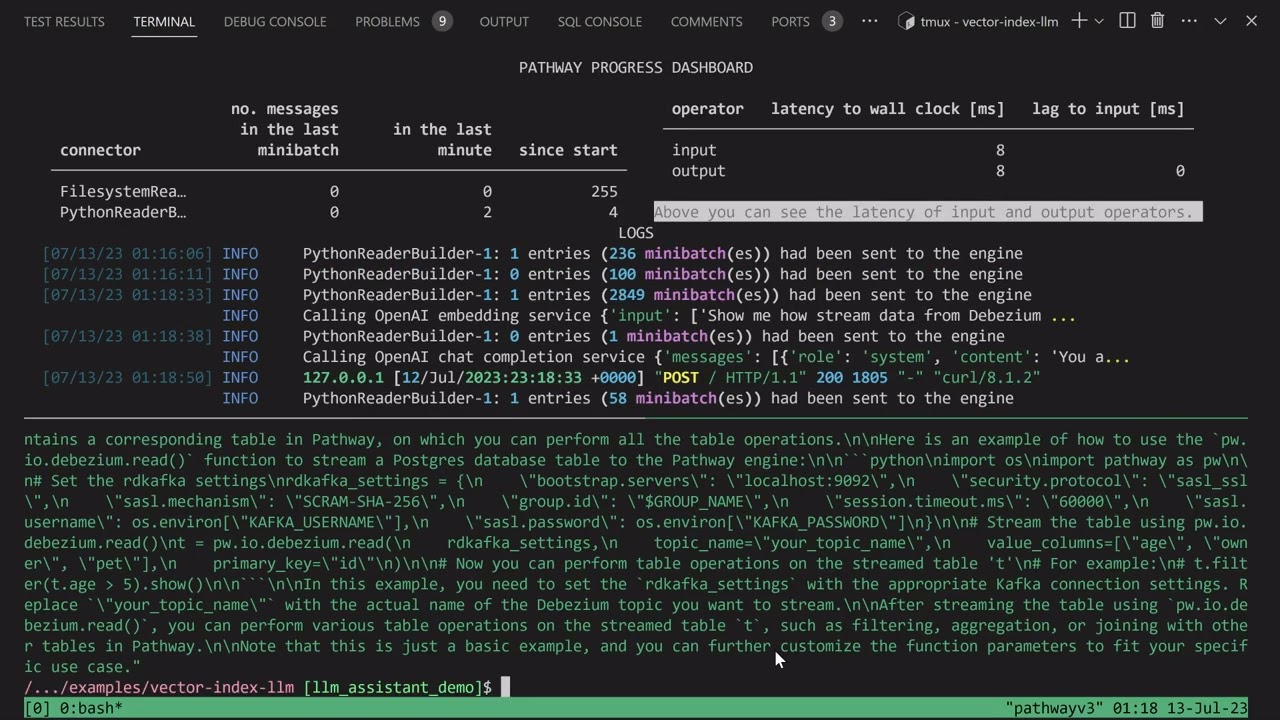

Ich präsentiere Pathways LLM-App – eine Python-Bibliothek, die sorgfältig entwickelt wurde, um die Entwicklung bahnbrechender KI-Anwendungen zu beschleunigen.

Hauptmerkmale

- Entwickelt für lokale ML-Modelle: Die LLM-App ist für die Ausführung mit lokalen ML-Modellen konfiguriert und bleibt innerhalb der Unternehmensgrenzen.

- Datenverarbeitung in Echtzeit: Diese Bibliothek verwaltet Live-Datenquellen, einschließlich Newsfeeds, APIs und Kafka-Datenströme, mit Benutzerberechtigungen und robuster Sicherheit.

- Reibungslose Benutzersitzungen: Der Abfrageerstellungsprozess der Bibliothek verwaltet Benutzersitzungen effizient und sorgt so für nahtlose Interaktionen.

Mit diesem außergewöhnlichen Vorteil können Sie bei der Beantwortung von Benutzeranfragen sofortige Antworten liefern, die menschliche Interaktionen widerspiegeln. Diese bemerkenswerte Leistung wird erreicht, indem die neuesten Erkenntnisse, die in Ihren Datenquellen verborgen sind, effektiv genutzt werden.

LLMFlows

LLMFlows entsteht als Framework, das darauf zugeschnitten ist, die Entwicklung von Large Language Model (LLM)-Anwendungen wie Chatbots, Frage-Antwort-Systemen und Agenten zu vereinfachen, zu klären und transparent zu machen.

Die Komplexität kann in realen Szenarien aufgrund komplizierter Beziehungen zwischen Eingabeaufforderungen und LLM-Aufrufen noch erhöht werden.

Die Entwickler von LLMFlows stellten sich eine explizite API vor, die es Benutzern ermöglicht, sauberen und verständlichen Code zu erstellen. Diese API optimiert die Erstellung komplexer LLM-Interaktionen und gewährleistet einen nahtlosen Fluss zwischen verschiedenen Modellen.

Hauptmerkmale

- Konfigurieren Sie LLM-Klassen nahtlos und wählen Sie dabei bestimmte Modelle, Parameter und Einstellungen sorgfältig aus.

- Sorgen Sie für robuste LLM-Interaktionen mit automatischen Wiederholungsversuchen bei Modellaufruffehlern und stellen Sie so die Zuverlässigkeit sicher.

- Optimieren Sie Leistung und Effizienz, indem Sie Async Flows für die parallele Ausführung von LLMs nutzen, wenn Eingaben verfügbar sind.

- Integrieren Sie personalisierte String-Manipulationsfunktionen direkt in Abläufe und ermöglichen Sie so maßgeschneiderte Texttransformationen über LLM-Aufrufe hinaus.

- Behalten Sie mit Rückrufen die vollständige Kontrolle und Übersicht über LLM-basierte Anwendungen und bieten Sie umfassende Überwachung und Einblick in die Ausführungsprozesse.

Die Klassen von LLMFlows bieten Benutzern uneingeschränkte Autorität ohne versteckte Eingabeaufforderungen oder LLM-Aufrufe.

Promptfoo

Beschleunigen Sie Auswertungen durch Caching und gleichzeitiges Testen mit promptfoo. Es bietet eine Befehlszeilenschnittstelle (CLI) und eine Bibliothek und ermöglicht die Bewertung der LLM-Ausgabequalität.

Hauptmerkmale

- Kampferprobte Zuverlässigkeit: Promptfoo wurde sorgfältig entwickelt, um LLM-Apps zu evaluieren und zu verbessern, die über 10 Millionen Benutzer in einer Produktionsumgebung bedienen. Die bereitgestellten Werkzeuge sind flexibel und an verschiedene Setups anpassbar.

- Benutzerfreundliche Testfälle: Definieren Sie Auswertungen, ohne zu programmieren oder sich mit umständlichen Notizbüchern auseinanderzusetzen. Ein einfacher, deklarativer Ansatz rationalisiert den Prozess.

- Sprachflexibilität: Egal, ob Sie Python, Javascript oder eine andere Sprache verwenden, promptfoo geht auf Ihre Vorlieben ein.

Darüber hinaus ermöglicht promptfoo das systematische Testen von Eingabeaufforderungen anhand vordefinierter Testfälle. Dies hilft bei der Bewertung der Qualität und der Identifizierung von Regressionen, indem es den direkten direkten Vergleich der LLM-Ergebnisse erleichtert.

ZenML

Sag hallo zu ZenML – ein anpassungsfähiges Open-Source-Tool, das Fachleuten und Organisationen die Welt der Pipelines für maschinelles Lernen einfacher machen soll. Stellen Sie sich vor, Sie hätten ein Tool, mit dem Sie Pipelines für maschinelles Lernen erstellen können, die für den realen Einsatz bereit sind, egal wie komplex Ihr Projekt ist.

ZenML trennt die technischen Dinge vom Code und erleichtert so die Zusammenarbeit von Entwicklern, Datenwissenschaftlern, MLOps-Experten und ML-Ingenieuren. Dies bedeutet, dass Ihre Projekte reibungsloser von der Ideenphase zur Umsetzung übergehen können.

Hauptmerkmale

- Für Datenwissenschaftler: Konzentrieren Sie sich auf das Erstellen und Testen von Modellen, während ZenML Ihren Code für den realen Einsatz vorbereitet.

- Für MLOps-Infrastrukturexperten: Komplexe Systeme schnell einrichten, verwalten und bereitstellen, damit Ihre Kollegen sie problemlos nutzen können.

- Für ML-Ingenieure: Bewältigen Sie jeden Schritt Ihres maschinellen Lernprojekts von Anfang bis Ende mit Hilfe von ZenML. Das bedeutet, dass Sie weniger Arbeit abgeben müssen und mehr Klarheit über den Weg Ihres Unternehmens haben.

ZenML ist für jeden geeignet – egal, ob Sie ein Profi oder Teil einer Organisation sind. Es verfügt über eine Methode zum Schreiben von Code, die für maschinelle Lernaufgaben entwickelt wurde, und funktioniert gut mit jedem Cloud-Dienst oder Tool, das Sie verwenden. Darüber hinaus hilft es Ihnen, Ihr Projekt an einem Ort zu verwalten, sodass Sie sich nicht um das Jonglieren verschiedener Dinge kümmern müssen. Schreiben Sie Ihren Code einfach einmal und verwenden Sie ihn problemlos auf anderen Systemen.

Letzter Gedanke

Denken Sie bei dieser aufregenden Odyssee immer daran, dass jede Plattform einen eigenen Schlüssel bietet, mit dem Sie Ihre KI-Ambitionen verwirklichen können. Ihre Wahl hat die Macht, Ihren Weg zu gestalten, also wählen Sie mit Bedacht!

Sie können auch einige erkunden KI-Tools für Entwickler um Apps schneller zu erstellen.

-

Rishav ist Absolvent der Informatik und des Ingenieurwesens und hat 2019 seinen B.Tech abgeschlossen. Seine Leidenschaft für die Erkundung der Welt der Technologie hat ihn in den letzten Jahren dazu veranlasst, sich der Entwicklung von Inhalten zu widmen. Für Rishav ist Technologie nicht nur… Mehr Blogartikel

-

Narendra Mohan Mittal ist Senior Digital Branding Strategist und Content Editor mit über 12 Jahren vielseitiger Erfahrung. Er verfügt über einen M-Tech (Goldmedaillengewinner) und B-Tech (Goldmedaillengewinner) in Informatik und Ingenieurwesen.

... Mehr Blogartikel