Auflistung der beliebtesten Deepfake-Betrügereien.

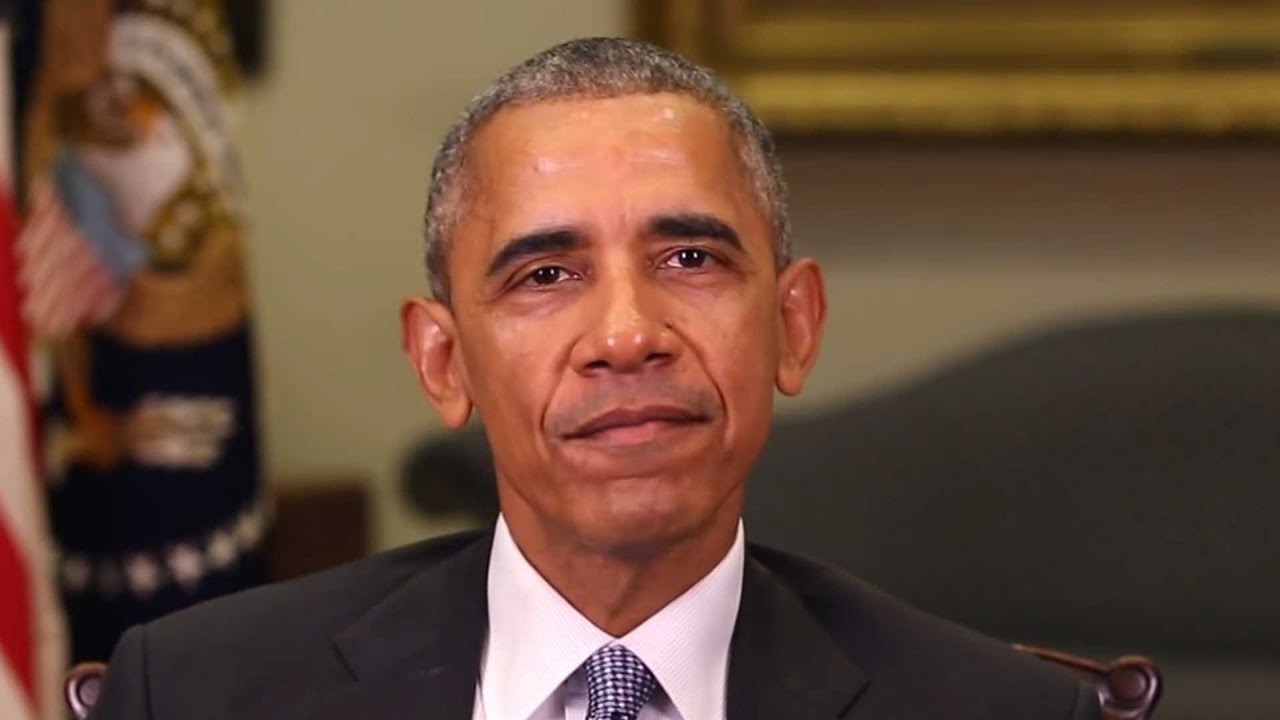

Beginnen wir mit dieser „besonderen“ Ansprache von „POTUS“ Joe Biden:

Dies ähnelt ein wenig dem, wie ein Deep-Fake-(Sprach-)Betrug aussehen kann. Eigentlich war das kostenlos Tool zum Klonen von KI-Stimmen, und ich habe etwas mehr als fünf Minuten damit verbracht, den Text zu schreiben (mit ChatGPT) und einzufügen, um ihn in (Bidens) Rede umzuwandeln.

Allerdings sind Deep-Fake-Betrügereien raffinierter. Alles, was Sie brauchen, sind ein paar hochwertige Fotos, Videos oder Audioaufnahmen des Motivs (Opfers) und eine leistungsstarke Grafikkarte, um loszulegen.

Aber wir sind nicht hier, um darüber zu diskutieren, wie man etwas erschafft Deepfake-Videos. Darum geht es auch nicht Deepfakes entdecken.

Stattdessen gibt dieser Artikel eine kurze Einführung in Deepfakes und erwähnt einige solcher Betrügereien, vor denen Sie sich in Acht nehmen sollten.

Was sind Deepfakes?

Deepfake kombiniert zwei Begriffe: Tief (aus Deep Learning, das zu ihrer Erstellung verwendet wird) und Fälschung (Angabe der Art der Ausgabe).

Kurz gesagt: Deep-Learning-Algorithmen werden eingesetzt, um aus hochauflösenden Originalinhalten überzeugende Bilder, Audio- oder Videoinhalte zu erstellen.

Dies ist ein klassisches Deepfake-Beispiel und fühlt sich bis zu einem gewissen Grad effektiv an. Aber sie ist immer noch fünf Jahre alt und die Technologie schreitet rasant voran.

Und das dient nicht immer dem Spaß oder der Demonstration der KI-Fähigkeiten einer Person. Ein solch schwerwiegender Fall ist, wenn „Mr. Wolodymyr Selenskyj wird von seinen Streitkräften aufgefordert, sich im weiteren Verlauf zu ergeben Russland-Ukraine-Krieg.

Leider ist dies kein solcher Fall. Gemäß der Regula Forensics 2023-Bericht37 % der weltweiten Unternehmen waren mit Deepfake-Sprachbetrug konfrontiert, 29 % erlebten Betrug mit synthetischen Videos und 46 % erlebten Identitätsdiebstahlversuche.

Folglich geht es nicht nur um Unterhaltung, und Deepfake wird häufig zur Verbreitung von Fehlinformationen eingesetzt und auf viele andere Arten missbraucht, was für die Opfer gefährlich und belastend sein kann.

Außerdem ist die Bekämpfung von Deepfake-Inhalten nicht einfach. Sie sind die Nebeneffekte erheblicher Fortschritte in der KI-Technologie und der Tatsache, dass solche Tools mittlerweile allgemein für die öffentliche Nutzung verfügbar sind.

Daher ist die größte und häufigste Verteidigung, die wir haben, das Bewusstsein.

Lassen Sie uns also an diesen Aspekten arbeiten und einen Blick auf die Arten von Deepfake-Betrügereien werfen.

Arten von Deepfake-Betrug

Basierend auf dem Inhalt und dem Ziel lassen sich Deepfake-Betrügereien in einige Formen einteilen, wie zum Beispiel:

- Video-Imitation

- Gefälschte Nachrichten

- Gefälschte Interviews

- Sprachbetrug

- Honigfang

- Kundensupport

- Referenzen

In weiteren Abschnitten wird ausführlich auf diese und einige ihrer Modifikationen eingegangen.

Video Impersonation

Dies ist ein bekannter Deepfake-Betrug, bei dem wir ein erfundenes Video sehen, das im Allgemeinen einem hochkarätigen Ziel ähnelt. Ein typisches Opfer kann ein Präsident eines Landes (wie der Obama-Deepfake), ein beliebter Hollywoodstar oder der CEO eines bekannten Unternehmens sein.

Was sie zu leichten Zielen macht, ist die öffentliche Zugänglichkeit ihrer Bilder, Reden usw., denn die Tools, die Deepfake-Videos erstellen, funktionieren gut mit unterschiedlichen Eingaben und zeigen unterschiedliche Emotionsbereiche, Gesichtswinkel, Lichtverhältnisse, Hintergründe und mehr.

Die Absicht eines solchen Identitätswechsels kann schlichter Spaß, ein Erpressungsversuch, eine politische Motivation, eine Verleumdung oder irgendetwas anderes sein.

In seltenen Fällen sieht man möglicherweise gefälschte Videos von Familienmitgliedern, die um Geld oder Zugang zu wertvollen Gegenständen bitten.

Fake News

Der häufigste Deepfake-Betrug sind Fake News. Solche Online-Desinformationskampagnen bergen Risiken, die in heiklen Situationen wie Unruhen oder Kriegen tödlich sein können.

Darüber hinaus kann es Persönlichkeiten des öffentlichen Lebens verleumden, wenn ihre Fake-Nachbildung Kommentare abgibt, die sie in der Realität nie gemacht hätten.

Was der Propaganda hilft, sind die sozialen Medien und Streaming-Plattformen wie YouTube, die dazu beitragen, dass sich solche Fake News wie ein Lauffeuer verbreiten. Schließlich entsteht eine Atmosphäre, in der normale Benutzer über die Authentizität von allem, was sie sehen, verwirrt sind.

Fake Interviews

Es erübrigt sich zu erwähnen, dass Fake-Interviews mithilfe der Deepfake-Technologie auf völlig abgelegene Arbeitsplätze im Homeoffice abzielen. Bei diesen Betrügereien wird versucht, Videos in Echtzeit über Konferenzprogramme wie Zoom zu fälschen.

Das Zielunternehmen riskiert nicht nur, einen unterdurchschnittlichen Kandidaten zu finden, sondern auch, seine Vermögenswerte einer betrügerischen Person preiszugeben. Und basierend auf den Geschäften des Unternehmens kann dies nicht nur ihre eigenen Ressourcen schädigen, sondern auch die Interessen ihres Landes gefährden.

Ein einfacheres Ziel von Deepfake-Interviews kann darin bestehen, in hochwertigen Währungen bezahlt zu werden.

Auf der anderen Seite können Betrüger von unschuldigen Kandidaten eine Gebühr für Vorstellungsgespräche verlangen, um sie vor „Branchenmagnaten“ zu locken und ihnen die Chance auf ihren Traumjob zu verschaffen.

Voice Fraud

Ähnlich wie Deepfake-Videos und -Bilder ist auch die synthetische Stimme ein weiterer Faktor, der die Liste solcher technologiegestützten Tricks ergänzt.

In einem solchen Fall hörte Jennifer DeStefano, eine Einwohnerin von Arizona, ihre 15-jährige Tochter am Telefon schluchzen, während eine männliche Stimme 1 Million Dollar für die Freilassung forderte. Die Mutter war überzeugt, dass ihr Kind in Gefahr sei. Bevor sie über die Zahlung nachdenken konnte, rief ihre Freundin ihren Mann an und bestätigte, dass ihre Tochter in Sicherheit sei.

Frau DeStefano erzählte später von der Tortur, dass sie der Stimme völlig geglaubt habe, nicht nur wegen des Klangs, sondern wegen der gesamten Klangwiedergabe, die genau mit der Art und Weise übereinstimmte, wie ihre Tochter normalerweise spricht.

Dabei handelt es sich um Voice-Cloning, das mit Hilfe der rohen Audio-Samples der Quelle durchgeführt wird.

Honeytraps

Gemäß der traditionellen Honeytrap-Definition wird das Subjekt dazu überredet, eine Beziehung einzugehen, um vertrauliche Informationen zu erpressen. Honeytraps zielen in der Regel auf hochrangige Personen ab, beispielsweise auf Mitarbeiter der Streitkräfte, hochrangige Regierungsbeamte, im Dienste von Politikern usw.

Mit der Deepfake-Technologie sind diese Honeytrapes größtenteils online und können von jedem in großem Umfang durchgeführt werden. Dies bedeutet, dass das Opfer möglicherweise Beziehungsanfragen von at erhälttractive Partner über soziale Medien, die schnell mit dem Endziel der finanziellen oder informationellen Erpressung vertraut werden.

Solche Deepfake-Betrügereien sind in der Regel begehrte Operationen, die ihren Lauf nehmen, bevor sie die endgültige Falle stellen.

Customer Support

Betrügereien beim technischen Support kommen sehr häufig vor. Sie haben vielleicht schon von Betrügereien gehört, bei denen ein „Microsoft“-Typ Sie zur Bezahlung der „schwerwiegenden“ Probleme Ihres Computers auffordert.

Vor Deepfake verrieten ihre Akzente oder ungewöhnlichen Sprachmuster die böswilligen Versuche. Aber jetzt verfügen diese Betrüger über KI-Superkräfte, die unschuldige Benutzer leicht zu der Annahme verleiten können, dass sie tatsächlich mit einem legitimen Unternehmensvertreter sprechen.

Testimonials

Viele von uns lesen Kundenrezensionen, bevor sie ein Produkt kaufen. Ebenso ist das Ansehen der Video-Testimonials eine weitere Einkaufsgewohnheit, die sich bisher als hilfreich erwiesen hat.

Bei dieser Art von Deepfake-Betrug bürgen mehrere Personen für ein schlechtes Produkt, beeinflussen die Kaufentscheidungen und verschwenden Geld und Zeit der Kunden.

Es gibt viele mehr!

Was sehen Sie im Internet außer dem Text?

Ich würde Videos, Bilder und Audio sagen. All dies kann mit dieser KI-Technologie manipuliert werden, was das Internet in nicht allzu ferner Zukunft zu einem Nährboden für Betrug machen wird. Darüber hinaus wird die Erstellung von Deepfakes im Laufe der Zeit immer einfacher, was es für einen durchschnittlichen Internetnutzer schwierig macht, „richtig“ informiert zu bleiben.

In einer solchen Situation, in der es kaum etwas gibt, was dem weitverbreiteten Missbrauch von Technologie Einhalt gebieten kann, sollten wir zumindest versuchen, auf dem Laufenden zu bleiben.

PS: Kommen wir zu den unterhaltsamen Anwendungen: Sie haben diese Deepfake-Apps um einige der besten Memes zu erstellen, um die sozialen Medien im Sturm zu erobern.

-

Hitesh arbeitet als leitender Autor bei Geekflare und beschäftigt sich mit Cybersicherheit, Produktivität, Spielen und Marketing. Darüber hinaus verfügt er über einen Masterabschluss in Verkehrstechnik. In seiner Freizeit spielt er hauptsächlich mit seinem Sohn, liest oder lügt … Mehr Blogartikel

-

Narendra Mohan Mittal ist Senior Digital Branding Strategist und Content Editor mit über 12 Jahren vielseitiger Erfahrung. Er verfügt über einen M-Tech (Goldmedaillengewinner) und B-Tech (Goldmedaillengewinner) in Informatik und Ingenieurwesen.

... Mehr Blogartikel