Als Kind habe ich es geliebt, Zeichentrickfilme mit Autos zu sehen, die scheinbar selbst fuhren. Ich fragte mich, ob solche Autos real sein könnten und ob sich darin winzige Roboter befänden, die sie auf magische Weise antreiben könnten.

Mit zunehmendem Alter werden selbstfahrende Autos immer realer! Ich bin wirklich fasziniert von ihnen. Verstehen sie beispielsweise, wann sie an Stoppschildern und roten Ampeln anhalten müssen? Können sie überhaupt Tiere und Menschen sehen, die auf der Straße herumlaufen? Und wie wäre es mit dem Autofahren, wenn es draußen ganz dunkel ist oder das Wetter ganz regnerisch oder schneereich ist?

Reden wir über selbstfahrende Autos! Das sind Autos, die ohne menschlichen Fahrer selbstständig fahren können. Unternehmen wie Tesla und Waymo nutzen intelligente Computertechniken tiefe Lernen, um diese Autos superschlau zu machen. Deep Learning hilft den Autos dabei, coole Dinge zu tun, etwa Verkehrszeichen zu verstehen und selbst bei schlechtem Wetter sicher zu fahren. Es geht darum, mithilfe fortschrittlicher Technologie die Art und Weise zu gestalten, wie wir uns in Zukunft fortbewegen werden!

History

Die Geschichte selbstfahrender Autos gleicht einem langen, aufregenden Abenteuer. Stellen Sie sich die 1920er Jahre vor, als autonome Fahrzeuge für die Menschen noch ein Traum waren. Ein erfinderischer Geist, Francis Houdina, zeichnete sich durch die Entwicklung eines Autos aus, das den Linien auf der Straße folgte. Zur Führung waren jedoch spezielle, versteckte Leitungen unter der Straße erforderlich.

Gehen wir vorwärts in die 1980er und 1990er Jahre, die brillanten Köpfe von Carnegie Mellon University waren auf etwas Großes gefasst. Sie entwickelten Autos, die mithilfe von Kameras „sehen“ konnten und ihnen dabei halfen, sich auf den belebten Straßen der Stadt zurechtzufinden. Diese Autos waren wie lernende Entdecker, die das Fahren entdeckten, indem sie sich umschauten.

Dann kam im Jahr 2004 ein bedeutender Moment, vor dem Hintergrund einer Wüstenherausforderung. Selbstfahrende Autos kamen auf den Plan und versuchten ein hartes Rennen – ein Rennen, das sie nicht gewannen, aber es war ein Anfang. Betrachten Sie es als ihr Trainingsgelände, um bessere Fahrer zu werden.

Der eigentliche Durchbruch gelang jedoch in den 2000er- und 2010er-Jahren, als große Unternehmen dies taten Tesla, Uber und Google (Jetzt Waymo) stieg in den Automobilsektor ein. Google begann 2009 mit dem Testen selbstfahrender Autos. Im Jahr 2015 führten die Autos von Tesla eine Funktion ein, mit der sie auf bestimmten Straßen teilweise selbst fahren konnten. Sie konnten ohne ständige menschliche Kontrolle lenken und auf der Straße bleiben.

Je mehr Unternehmen sich dem Rennen anschlossen, desto härter wurde der Wettbewerb um die Entwicklung völlig selbstfahrender Autos. Stellen Sie sich Teams von Erfindern vor, die gegeneinander antreten, um Autos zu bauen, die ohne Menschen zum Lenken fahren können.

Aber die Geschichte geht weiter. Wir arbeiten immer noch daran, autonom fahrende Autos zu bauen, was die Art und Weise, wie wir reisen, verändern würde. Dieses Abenteuer gibt es immer noch und es bedeutet, dass wir sicherer und einfacher reisen könnten, weil diese schicken selbstfahrenden Autos immer besser werden.

How Do Self-Driving Cars Work?

Selbstfahrende Autos sind wie superschlaue Entscheidungsträger! Sie nutzen Kameras, LiDAR, RADAR, GPS und Trägheitssensoren, um Daten über ihre Umgebung zu sammeln. Anschließend verarbeiten spezielle Algorithmen, sogenannte Deep-Learning-Algorithmen, diese Daten, um zu verstehen, was um sie herum geschieht. Auf der Grundlage dieses Verständnisses treffen sie wichtige Entscheidungen für ein sicheres und reibungsloses Fahren.

Wenn wir herausfinden wollen, wie selbstfahrende Autos wirklich funktionieren, werfen wir einen genaueren Blick auf diese vier im Diagramm oben gezeigten Teile. Es ist wie das Lösen eines Puzzles – wenn wir jedes Teil verstehen, können wir das Gesamtbild der Funktionsweise dieser erstaunlichen Autos erkennen:

- Wahrnehmung

- Lokalisierung

- Prognose

- Decision Making

- Wegplanung auf hohem Niveau

- Verhaltensschiedsverfahren

- Motion Controller

Perception

# 1. Kamera

Kameras sind wie die Augen eines selbstfahrenden Autos – sie sind super wichtig! Sie helfen dem Auto zu wissen, was um es herum passiert. Diese Kameras erledigen unterschiedliche Aufgaben, z. B. herauszufinden, um welche Dinge es sich handelt, verschiedene Teile zu trennen und herauszufinden, wo sich das Auto befindet.

Um sicherzustellen, dass dem Auto nichts entgeht, sind überall Kameras angebracht – vorne, hinten, links und rechts. Diese Kameras arbeiten zusammen, um ein umfassendes Bild von allem rund um das Auto zu erstellen. Es ist wie die spezielle 360-Grad-Ansicht des Autos!

Diese Kameras dienen nicht nur der Show. Sie sind schlau. Manche blicken in die Ferne, bis zu 200 Meter, damit das Auto weiß, was vor ihm liegt. Andere konzentrieren sich auf Dinge in der Nähe, damit das Auto genau auf Details achten kann. Dieses Kamerateam hilft dem Auto, alles zu sehen und zu verstehen, so wie ein Freund es führt, damit es sicher fahren und gute Entscheidungen treffen kann.

Manchmal sind Kameras sehr hilfreich, beispielsweise beim Parken, da sie eine weite Sicht bieten und dabei helfen, gute Entscheidungen für vorsichtiges Fahren zu treffen.

Aber nur die Verwendung von Kameras zum Sehen von Dingen ist problematisch, insbesondere bei schwierigem Wetter wie Nebel, starkem Regen und nachts. In diesen Zeiten können die Bilder von Kameras seltsam und unordentlich aussehen, was wirklich unsicher sein kann.

Um diese herausfordernden Situationen zu bewältigen, benötigen wir spezielle Sensoren, die auch dann funktionieren, wenn es wirklich dunkel oder sogar völlig dunkel ist. Sie sollten auch in der Lage sein, die Entfernung von Dingen zu messen, ohne dass dafür Licht erforderlich ist, das wir sehen können. Wenn wir diese Sensoren in die Augen des Autos einbauen (Wahrnehmungssystem), kann das Auto bei schlechtem Wetter oder schlechter Sicht besser fahren. Dadurch kann das Auto sicherer fahren, was für jeden, der auf der Straße unterwegs ist, von Vorteil ist.

# 2. LiDAR

LiDAR, was „Light Detection And Ranging“ bedeutet, ist eine ausgefallene Technologie, die Laser verwendet, um herauszufinden, wie weit Dinge entfernt sind. LiDAR sendet Laserstrahlen aus und misst, wie lange es dauert, bis sie von Dingen zurückkommen.

Wenn LiDAR und Kameras zusammenarbeiten, helfen sie dem Auto, die Dinge klarer zu verstehen. Es erstellt eine 3D-Karte der Umgebung des Autos. Diese speziellen Informationen können dann von intelligenten Computerprogrammen eingesehen werden, die dem Auto dabei helfen, zu erraten, was andere Autos tun könnten. Dies ist nützlich, wenn die Straße schwierig ist, beispielsweise an stark befahrenen Kreuzungen, da das Auto andere Autos beobachten und sicher fahren kann.

Allerdings weist LiDAR Einschränkungen auf, die problematisch sein können. Während es nachts und in dunklen Umgebungen gut funktioniert, kann es bei Störungen durch Regen oder Nebel zu Problemen kommen, was möglicherweise zu Ungenauigkeiten in der Wahrnehmung führen kann. Um diese Probleme zu lösen, verwenden wir gleichzeitig LiDAR- und RADAR-Sensoren. Diese Sensoren liefern zusätzliche Informationen, die dem Auto helfen, die Dinge besser zu verstehen. Das Auto kann sicherer und besser selbstständig fahren.

# 3. RADAR

RADAR, was für Radio Detection and Ranging steht, wird seit langem im Alltag und auch beim Militär eingesetzt. RADAR wurde ursprünglich vom Militär zur Erkennung von Objekten eingesetzt und berechnet Entfernungen mithilfe von Radiowellensignalen. Heutzutage ist RADAR in vielen Autos von entscheidender Bedeutung, insbesondere in selbstfahrenden.

RADAR ist großartig, weil es bei jedem Wetter und Licht funktionieren kann. Anstelle von Lasern verwendet es Radiowellen, was es flexibel und äußerst nützlich macht. Allerdings gilt RADAR als verrauschter Sensor, was bedeutet, dass er Hindernisse auch dann erkennen kann, wenn die Kamera keine erkennt.

Das Gehirn des selbstfahrenden Autos kann durch all die zusätzlichen RADAR-Signale, die wir „Rauschen“ nennen, verwirrt werden. Um dies zu beheben, muss das Auto die RADAR-Informationen bereinigen, damit es gute Entscheidungen treffen kann.

Um die Daten zu bereinigen, müssen spezielle Tricks angewendet werden, um die starken Signale von den schwachen zu unterscheiden, etwa die wichtigen Dinge von den weniger wichtigen Dingen zu trennen. Um die Informationen noch besser zu verstehen, nutzt das Auto einen cleveren Trick namens Fast Fourier Transforms (FFT).

RADAR und LiDAR liefern Informationen über einzelne Punkte, wie Punkte auf Papier. Um diese Punkte besser zu verstehen, verwendet das Auto so etwas wie Gruppierung. Es ist, als würde man ähnliche Dinge zusammenfügen. Das Auto nutzt clevere statistische Methoden wie Euklidisches Clustering oder K-Means-Clustering, um ähnliche Punkte zu kombinieren und zu verstehen. Dadurch kann das Auto intelligenter und sicherer fahren.

Localization

In selbstfahrenden Autos spielen Lokalisierungsalgorithmen eine entscheidende Rolle bei der Bestimmung der Position und Ausrichtung des Fahrzeugs während der Navigation, bekannt als Visual Odometry (VO). VO funktioniert durch die Identifizierung und Zuordnung von Schlüsselpunkten in aufeinanderfolgenden Videobildern.

Das Auto betrachtet spezielle Punkte in den Informationen, wie Markierungen auf einer Karte. Danach verwendet das Auto Statistiken namens SLAM, um herauszufinden, wo sich Dinge befinden und wie sie sich bewegen. Dadurch weiß das Auto, was sich in der Umgebung befindet, etwa Straßen und Menschen.

Und um dies noch besser zu machen, nutzt das Auto sogenanntes Deep Learning. Es ist wie ein superintelligenter Computer.

Diese Tricks sorgen dafür, dass das Auto die Dinge sehr gut versteht. Neuronale Netze wie PoseNet und VLocNet++ nutzen Punktdaten, um die 3D-Position und Ausrichtung von Objekten abzuschätzen. Diese geschätzten 3D-Positionen und -Ausrichtungen können dann zur Ableitung der Szenensemantik verwendet werden, wie im Bild unten gezeigt. Wenn das Auto Mathematik und intelligente Computertricks anwendet, weiß es, wo es ist und was sich um es herum befindet. Dadurch kann das Auto selbstständig und sicher fahren.

Prediction

Das Verständnis menschlicher Fahrer ist in der Tat eine komplexe Aufgabe, da es dabei eher um Emotionen und Reaktionen als um einfache Logik geht. Da wir nicht wissen, was andere Fahrer tun werden, ist es für selbstfahrende Autos von entscheidender Bedeutung, ihre Handlungen gut einzuschätzen. Dies trägt zur Sicherheit im Straßenverkehr bei.

Stellen Sie sich selbstfahrende Autos vor, die überall Augen haben, wie eine 360-Grad-Ansicht. Dadurch können sie alles sehen, was passiert. Sie nutzen diese Informationen mit Deep Learning. Das Auto nutzt clevere Techniken, um vorherzusagen, was andere Fahrer tun könnten. Es ist vergleichbar mit einem Spiel, bei dem man im Voraus plant, gut abzuschneiden.

Die speziellen Sensoren in selbstfahrenden Autos sind wie ihre Augen. Sie helfen den Autos zu erkennen, welche Dinge auf Bildern zu sehen sind, Dinge in ihrer Nähe zu finden, zu wissen, wo sie sich befinden, und zu sehen, wo die Dinge enden. Dadurch kann das Auto erkennen, was sich in der Nähe befindet, und intelligente Entscheidungen treffen.

Während dem Training, tiefe Lernen Algorithmen modellieren komplexe Informationen aus Bildern und Wolkendatenpunkten, die von LiDARs und RADARs erhalten wurden. Während der tatsächlichen Fahrt (Inferenz) hilft dasselbe Modell dem Auto, sich auf mögliche Bewegungen vorzubereiten, einschließlich Bremsen, Anhalten, Verlangsamen, Spurwechsel und mehr.

Deep Learning ist wie ein smarter Helfer für das Auto. Dadurch versteht das Auto Dinge, bei denen es unsicher ist, erkennt seinen Standort und fährt besser. Dadurch bleibt das Fahren sicherer und reibungsloser.

Der schwierige Teil besteht jedoch darin, aus wenigen Optionen die beste Aktion auszuwählen. Die Wahl der richtigen Schritte erfordert sorgfältiges Überlegen, damit das Auto gut fährt und sicher bleibt.

Decision Making

Selbstfahrende Autos müssen in schwierigen Situationen wichtige Entscheidungen treffen, aber das ist nicht einfach. Dies liegt daran, dass Sensoren möglicherweise nicht immer korrekt sind und Menschen auf der Straße unerwartete Dinge tun können. Das Auto muss erraten, was andere tun und bewegen werden, um Unfälle zu vermeiden.

Um Entscheidungen treffen zu können, benötigt das Auto viele Informationen. Das Auto sammelt diese Informationen mithilfe von Sensoren und verwendet dann Deep-Learning-Algorithmen, um zu verstehen, wo sich Dinge befinden, und um vorherzusagen, was passieren könnte. Die Lokalisierung hilft dem Auto, seine Ausgangsposition zu erkennen, während die Vorhersage mehrere mögliche Aktionen basierend auf der Umgebung generiert.

Es bleibt jedoch die Frage: Wie wählt das Auto aus den vielen vorhergesagten Aktionen die beste aus?

Deep Reinforcement Learning (DRL) ist eine Technik zur Entscheidungsfindung und verwendet einen Algorithmus namens Markov-Entscheidungsprozess (MDP). MDP ist hilfreich, um abzuschätzen, wie sich Menschen auf der Straße in Zukunft verhalten könnten. Je mehr Dinge sich bewegen, desto komplizierter wird es. Das bedeutet, dass das selbstfahrende Auto über noch mehr Handlungsmöglichkeiten nachdenken muss.

Um der Herausforderung zu begegnen, die beste Bewegung für das Auto zu finden, wird das Deep-Learning-Modell mithilfe der Bayes'schen Optimierung optimiert. In einigen Fällen wird zur Entscheidungsfindung ein Rahmenwerk eingesetzt, das ein Hidden-Markov-Modell und eine Bayes'sche Optimierung kombiniert und es dem selbstfahrenden Auto ermöglicht, in verschiedenen komplexen Szenarien effektiv und sicher zu navigieren.

Die Entscheidungsfindung bei selbstfahrenden Autos folgt einem hierarchischen Prozess mit vier Schlüsselkomponenten:

Pfad- oder Routenplanung: Zu Beginn der Fahrt ermittelt das Auto die beste Route von seiner aktuellen Position zum gewünschten Ziel. Ziel ist es, unter verschiedenen möglichen Routen eine optimale Lösung zu finden.

Verhaltensschiedsverfahren: Das Auto muss die Route nach der Planung steuern. Das Auto erkennt statische Objekte wie Straßen und Kreuzungen, ist jedoch nicht in der Lage, die genauen Aktionen anderer Fahrer vorherzusagen. Um mit dieser Unsicherheit umzugehen, nutzen wir für die Planung intelligente Methoden wie Markov Decision Processes (MDPs).

Bewegungsplanung: Mit der geplanten Route und der Verhaltensebene, die bestimmt, wie darauf zu navigieren ist, koordiniert das Bewegungsplanungssystem die Bewegungen des Fahrzeugs. Das bedeutet, sicherzustellen, dass sich das Auto auf eine Weise bewegt, die für die darin befindlichen Personen sowohl sicher als auch komfortabel ist. Es denkt an Dinge wie Geschwindigkeit, Spurwechsel und die Umgebung.

Fahrzeug Kontrolle: Der letzte Schritt ist die Fahrzeugsteuerung, die den vom Bewegungsplanungssystem generierten Referenzpfad ausführt und sicherstellt, dass das Auto der beabsichtigten Flugbahn reibungslos und sicher folgt.

Durch die Unterteilung der Entscheidungsfindung in diese verschiedenen Teile können selbstfahrende Autos an komplizierten Orten gut und sicher fahren. Dies stellt sicher, dass die Passagiere eine reibungslose und komfortable Fahrt haben.

Convolutional Neural Networks

Faltungs-Neuronale Netze (CNNs) werden aufgrund ihrer Fähigkeit, räumliche Informationen, insbesondere Bilder, zu modellieren, häufig in selbstfahrenden Autos eingesetzt. CNNs zeichnen sich durch das Extrahieren von Merkmalen aus Bildern aus und sind daher hilfreich, um viele verschiedene Dinge herauszufinden.

In einem CNN erfassen verschiedene Schichten mit zunehmender Netzwerktiefe unterschiedliche Muster. Frühe Schichten erkennen einfache Merkmale wie Kanten, während tiefere Schichten komplexere Merkmale wie Objektformen (wie Blätter an Bäumen oder Reifen an Fahrzeugen) erkennen. Diese Anpassungsfähigkeit ist der Grund, warum CNNs ein zentraler Algorithmus in selbstfahrenden Autos sind.

Die Kernkomponente eines CNN ist die Faltungsschicht, die einen Faltungskern (Filtermatrix) verwendet, um lokale Bereiche des Eingabebildes zu verarbeiten.

Die Filtermatrix wird während des Trainings aktualisiert, um aussagekräftige Gewichte zu erhalten. Eine grundlegende Eigenschaft von CNNs ist die Gewichtsteilung, bei der dieselben Gewichtsparameter zur Darstellung verschiedener Transformationen verwendet werden, wodurch Verarbeitungsraum gespart und unterschiedliche Merkmalsdarstellungen ermöglicht werden.

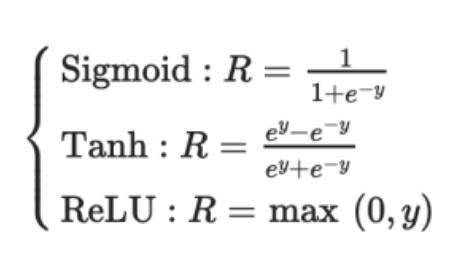

Die Ausgabe der Faltungsschicht wird normalerweise durch eine nichtlineare Aktivierungsfunktion wie Sigmoid, Tanh oder ReLU geleitet. ReLU wird bevorzugt, da es schneller konvergiert als die anderen. Außerdem durchläuft das Ergebnis häufig eine Max-Pooling-Schicht. Dadurch bleiben wichtige Details wie Hintergrund und Texturen aus dem Bild erhalten.

Drei wesentliche Eigenschaften von CNNs machen sie vielseitig und grundlegend für selbstfahrende Autos:

- Lokale rezeptive Felder

- Gemeinsame Gewichte

- Räumliche Probenahme

Diese Eigenschaften reduzieren eine Überanpassung und speichern kritische Darstellungen und Merkmale, die für die Bildklassifizierung, Segmentierung, Lokalisierung und mehr entscheidend sind.

Hier sind zwei CNN-Netzwerke, die von Unternehmen genutzt werden, die Pionierarbeit bei selbstfahrenden Autos leisten:

- HydraNet von Tesla

- ChauffeurNet von Google Waymo

Erfahren Sie mehr darüber Convolutional Neuronale Netze.

# 1. HydraNet von Tesla

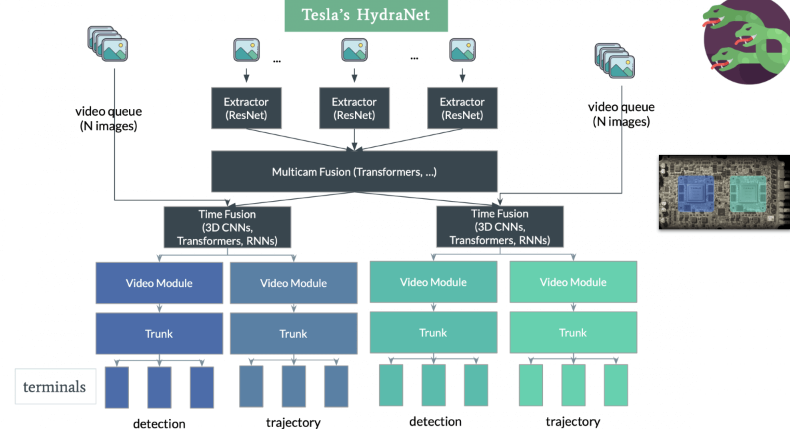

HydraNet ist eine dynamische Architektur, die von Ravi et al. eingeführt wurde. im Jahr 2018, hauptsächlich für die semantische Segmentierung in selbstfahrenden Autos entwickelt. Sein Hauptziel besteht darin, die Recheneffizienz während der Inferenz zu verbessern.

Der Begriff HydraNet Dabei werden verschiedene CNN-Netzwerke, sogenannte Branches, bestimmten Aufgaben zugewiesen. Jeder Zweig erhält verschiedene Eingaben, und das Netzwerk kann selektiv auswählen, welche Zweige während der Inferenz ausgeführt werden sollen, und letztendlich die Ausgaben verschiedener Zweige zusammenfassen, um eine endgültige Entscheidung zu treffen.

Im Zusammenhang mit selbstfahrenden Autos können Eingaben verschiedene Aspekte der Umgebung darstellen, beispielsweise statische Objekte (Bäume und Straßengeländer), Straßen und Fahrspuren, Ampeln usw. Diese Eingaben werden in separaten Zweigen trainiert. Während der Inferenz entscheidet der Gate-Mechanismus, welche Zweige aktiviert werden sollen, und der Kombinierer sammelt deren Ausgaben, um die endgültige Entscheidung zu treffen.

Tesla hat die HydraNet-Architektur angepasst und ein gemeinsames Backbone integriert, um die Herausforderungen bei der Trennung von Daten für einzelne Aufgaben während der Inferenz zu bewältigen. Das gemeinsame Backbone, normalerweise modifizierte ResNet-50-Blöcke, ermöglicht das Training des Netzwerks auf den Daten aller Objekte. Aufgabenspezifische Köpfe, die auf einer semantischen Segmentierungsarchitektur wie dem U-Net basieren, ermöglichen es dem Modell, für jede Aufgabe spezifische Ausgaben vorherzusagen.

Teslas HydraNet zeichnet sich durch seine Fähigkeit aus, eine Vogelperspektive zu projizieren und so aus jedem Winkel eine 3D-Darstellung der Umgebung zu erstellen. Diese verbesserte Dimensionalität hilft dem Auto bei der besseren Navigation. Bemerkenswerterweise erreicht Tesla dies ohne den Einsatz von LiDAR-Sensoren. Stattdessen sind nur zwei Sensoren erforderlich: eine Kamera und ein Radar. Die Effizienz von Teslas HydraNet ermöglicht es, Informationen von acht Kameras zu verarbeiten und eine Tiefenwahrnehmung zu erzeugen, was beeindruckende Fähigkeiten demonstriert, ohne dass zusätzliche LiDAR-Technologie erforderlich ist

# 2. ChauffeurNet von Google Waymo

ChauffeurNet ist ein RNN-basiertes neuronales Netzwerk, das von Google Waymo zum Trainieren selbstfahrender Autos mithilfe von Imitationslernen verwendet wird. Während es in erster Linie auf einem RNN zur Generierung von Fahrtrajektorien basiert, enthält es auch eine CNN-Komponente namens FeatureNet.

Dieses Faltungsmerkmalsnetzwerk extrahiert kontextbezogene Merkmalsdarstellungen, die von anderen Netzwerken gemeinsam genutzt werden, und wird zum Extrahieren von Merkmalen aus dem Wahrnehmungssystem verwendet.

Das Konzept hinter ChauffeurNet besteht darin, das selbstfahrende Auto durch Nachahmung von erfahrenen Fahrern mithilfe von Nachahmungslernen zu trainieren. Um die Einschränkung unzureichender realer Trainingsdaten zu überwinden, führten die Autoren des Artikels „ChauffeurNet: Learning to Drive by Imitating the Best and Synthesizing the Worst“ synthetische Daten ein.

Diese synthetischen Daten führen zu verschiedenen Abweichungen, wie z. B. einer Störung der Flugbahn, dem Hinzufügen von Hindernissen und der Schaffung unnatürlicher Szenen. Das Training des Autos mit synthetischen Daten erwies sich als effizienter als die Verwendung nur realer Daten.

In ChauffeurNet ist das Wahrnehmungssystem nicht Teil des End-to-End-Prozesses, sondern fungiert als Mittelebenensystem. Dadurch kann das Netzwerk über verschiedene Eingabevarianten des Wahrnehmungssystems verfügen. Das Netzwerk beobachtet von den Sensoren eine mittlere Darstellung der Szene und ahmt mithilfe dieser Eingabe zusammen mit synthetischen Daten das Fahrverhalten eines Experten nach.

Indem man die Wahrnehmungsaufgabe herausrechnet und eine hochrangige Vogelperspektive auf die Umgebung schafft, ChauffeurNet erleichtert das Transferlernen und ermöglicht dem Netzwerk, bessere Entscheidungen auf der Grundlage realer und simulierter Daten zu treffen. Das Netzwerk generiert Fahrtrajektorien, indem es auf der Grundlage der Darstellungen auf mittlerer Ebene iterativ aufeinanderfolgende Punkte im Fahrweg vorhersagt. Dieser Ansatz hat sich als vielversprechend erwiesen, selbstfahrende Autos effektiver zu trainieren und einen Weg zu sichereren und zuverlässigeren autonomen Fahrsystemen zu ebnen.

# 3. Teilweise beobachtbarer Markov-Entscheidungsprozess für selbstfahrende Autos

Teilweise beobachtbarer Markov-Entscheidungsprozess (POMDP) ist ein mathematischer Rahmen, der im Zusammenhang mit selbstfahrenden Autos verwendet wird, um Entscheidungen unter Unsicherheit zu treffen. In realen Szenarien verfügen selbstfahrende Autos aufgrund von Sensorrauschen, Verdeckungen oder unvollständigen Wahrnehmungssystemen oft nur über begrenzte Informationen über ihre Umgebung. POMDP ist darauf ausgelegt, eine solche teilweise Beobachtbarkeit zu bewältigen und optimale Entscheidungen zu treffen, indem sowohl Unsicherheit als auch verfügbare Beobachtungen berücksichtigt werden.

In einem POMDP agiert der Entscheidungsagent in einer Umgebung mit teilweise beobachtbaren Zuständen. Der Agent ergreift Maßnahmen und die Umgebung geht probabilistisch in neue Zustände über. Allerdings erhält der Agent nur Teilbeobachtungen oder verrauschte Informationen über den wahren Zustand der Umgebung. Das Ziel besteht darin, eine Richtlinie zu finden, die die erwartete kumulative Belohnung über die Zeit maximiert und dabei die Unsicherheit in der Umgebung und die Beobachtungen des Agenten berücksichtigt.

Im Zusammenhang mit selbstfahrenden Autos ist POMDP besonders nützlich für Aufgaben wie Bewegungsplanung, Flugbahnvorhersage und Interaktion mit anderen Verkehrsteilnehmern. Das selbstfahrende Auto kann mithilfe von POMDP Entscheidungen über Spurwechsel, Geschwindigkeitsanpassungen und Interaktionen mit Fußgängern und anderen Fahrzeugen treffen und dabei die Unsicherheit in der Umgebung berücksichtigen.

Das POMDP besteht aus sechs Komponenten und kann als POMDP bezeichnet werden

M:= (I, S, A, R, P, γ)

woher,

I: Beobachtungen

S: Endliche Menge von Zuständen

A: Endliche Menge an Aktionen

R: Belohnungsfunktion

P: Übergangswahrscheinlichkeitsfunktion

γ: Abzinsungsfaktor für zukünftige Belohnungen.

POMDPs können rechentechnisch eine Herausforderung darstellen, da mehrere mögliche Zustände und Beobachtungen berücksichtigt werden müssen. Allerdings werden häufig fortschrittliche Algorithmen wie Glaubensraumplanung und Monte-Carlo-Methoden eingesetzt, um die optimale Richtlinie effizient anzunähern und eine Entscheidungsfindung in Echtzeit in selbstfahrenden Autos zu ermöglichen.

Durch die Integration von POMDP in ihre Entscheidungsalgorithmen können selbstfahrende Autos komplexe und unsichere Umgebungen effektiver und sicherer navigieren, indem sie die Unsicherheit der Sensorwerte berücksichtigen und fundierte Entscheidungen treffen, um ihre beabsichtigten Ziele zu erreichen.

Das selbstfahrende Auto, das als Agent fungiert, lernt, indem es mit der Umgebung interagiert Verstärkung lernen (RL), eine Art maschinelles Lernen. Zustand, Aktion und Belohnung sind die drei wichtigen Variablen im Kern Deep Reinforcement Learning (DRL).

Bundesstaat: Beschreibt die aktuelle Situation des selbstfahrenden Autos zu einem bestimmten Zeitpunkt, beispielsweise seine Position auf der Straße.

Action: Stellt alle möglichen Bewegungen dar, die das Auto ausführen kann, einschließlich Entscheidungen wie Spurwechsel oder Geschwindigkeitsanpassungen.

Belohnen: Gibt dem Auto eine Rückmeldung, wann immer es eine bestimmte Aktion durchführt. Die Belohnung kann positiv oder negativ sein, und das Ziel von DRL besteht darin, die kumulativen Belohnungen zu maximieren.

Im Gegensatz zum überwachten Lernen, bei dem dem Algorithmus explizit die richtigen Aktionen zugewiesen werden, lernt DRL, indem es die Umgebung erkundet und auf der Grundlage seiner Aktionen Belohnungen erhält. Das neuronale Netzwerk des selbstfahrenden Autos wird auf Wahrnehmungsdaten trainiert, zu denen auch Merkmale gehören, die von Convolutional Neural Networks (CNNs) extrahiert werden.

Anschließend werden DRL-Algorithmen auf diese Darstellungen trainiert, bei denen es sich um niederdimensionale Transformationen der Eingabe handelt, was zu einer effizienteren Entscheidungsfindung während der Inferenz führt.

Das Training selbstfahrender Autos in realen Szenarien ist gefährlich und unpraktisch. Stattdessen werden sie darin geschult Simulatoren, wo keine Gefahr für die Sicherheit von Menschen besteht.

Einige Open-Source-Simulatoren sind:

Durch die Kombination von Wahrnehmungsdaten mit verstärkendem Lernen können selbstfahrende Autos lernen, sich in komplexen Umgebungen zurechtzufinden, sichere und optimale Entscheidungen zu treffen und im Umgang mit realen Fahrszenarien besser zurechtzukommen.

Häufig gestellte Fragen (FAQs)

Autonome Fahrzeuge, allgemein als selbstfahrende Autos bezeichnet, sind Automobile mit modernsten Sensoren und künstlicher Intelligenz, die selbstständig navigieren und fahren können. Diese Fahrzeuge bewerten ihre Umgebung und treffen mithilfe von Kameras, LiDAR, RADAR und hochentwickelten Algorithmen Fahrentscheidungen.

Bei der Entwicklung selbstfahrender Autos steht Sicherheit an erster Stelle. Um sicherzustellen, dass sie den hohen Sicherheitsvorschriften entsprechen, werden diese Fahrzeuge gründlichen Tests und Simulationen unterzogen. Obwohl es während der Tests zu Zwischenfällen kam, besteht das ultimative Ziel darin, selbstfahrende Autos sicherer zu machen als von Menschen gesteuerte.

Extreme Wetterbedingungen wie starker Regen oder Schnee könnten selbstfahrende Autos vor Probleme stellen. Ungünstiges Wetter kann die Genauigkeit der Sensoren beeinträchtigen und die Fahrfähigkeit beeinträchtigen. Ingenieure versuchen ständig, die Funktion der Technologie bei widrigen Wetterbedingungen zu verbessern.

Die Legalität autonomer Fahrzeuge variiert je nach Land und Standort. Um autonome Fahrzeuge zu ermöglichen, überarbeiten viele Gerichtsbarkeiten ihre Gesetze und Vorschriften. In einigen Gebieten sind Tests und begrenzter Einsatz selbstfahrender Autos bereits erlaubt.

Die meisten derzeit verfügbaren selbstfahrenden Autos verfügen über einen Automatisierungsgrad der Stufen 2 oder 3, bei dem sie manchmal menschliche Hilfe benötigen. Die Branche strebt jedoch danach, höhere Automatisierungsgrade zu erreichen, beispielsweise Level 4 oder Level 5, bei denen menschliches Eingreifen minimal oder unnötig wird.

Fazit

Zusammenfassend lässt sich sagen, dass selbstfahrende Autos die Automobilindustrie verändern können, indem sie die Effizienz und Sicherheit im Straßenverkehr verbessern. Wir haben alle wesentlichen Komponenten untersucht, die diese autonomen Autos unterstützen, einschließlich LiDAR, RADAR, Kameras und fortschrittliche Algorithmen.

Auch wenn die Fortschritte vielversprechend sind, gibt es immer noch große Herausforderungen, die es zu bewältigen gilt. Derzeit befinden sich selbstfahrende Autos auf Stufe 2 von Stufe 5 und erfordern in bestimmten Szenarien menschliches Eingreifen. Durch anhaltendes Engagement und Innovation kommen wir jedoch der Erreichung vollständiger Autonomie immer näher.

Key Take Away

Fortschrittliche Algorithmen: Eine weitere Optimierung der Algorithmen ist entscheidend, um die Straßenwahrnehmung zu verbessern, insbesondere unter schwierigen Bedingungen, bei denen möglicherweise Straßenmarkierungen und Schilder fehlen.

Verfeinerung der Wahrnehmungsmodalität: Die Verbesserung der Genauigkeit und Effizienz der Erfassungsmodalitäten für die Kartierung und Lokalisierung wird entscheidend dazu beitragen, ein höheres Maß an Autonomie zu erreichen.

Fahrzeug-zu-Fahrzeug-Kommunikation: Die Schaffung eines vernetzten und intelligenten Straßenökosystems wird durch die Verfolgung der Fahrzeug-zu-Fahrzeug-Kommunikation ermöglicht.

Mensch-Maschine-Interaktion: Um die öffentliche Akzeptanz selbstfahrender Technologien zu fördern, müssen Probleme im Zusammenhang mit der Mensch-Maschine-Interaktion untersucht und angegangen werden.

Zukunftsaussichten: Trotz der Schwierigkeiten sind die bisherigen Erfolge bemerkenswert, und durch fortlaufende Zusammenarbeit und Forschung bieten selbstfahrende Autos das Potenzial, ein sichereres und effektiveres Transportumfeld für alle zu schaffen.

Wir sind alle auf dem gleichen Weg hin zu völlig autonomen, selbstfahrenden Autos. Indem wir Herausforderungen lösen und Innovationen vorantreiben, nähern wir uns einer Zeit, in der Fahrzeuge unsere Straßen reibungslos bewältigen und so die Sicherheit, die Umwelt und den Komfort für alle verbessern.

Vielleicht erfahren Sie jetzt mehr darüber räumliches Rechnen und seine Anwendung bei der Entwicklung selbstfahrender Autos.

-

-

Usha, Chefredakteurin bei Geekflare, hat einen Master-Abschluss in Computeranwendungen. Sie arbeitet seit 6 Jahren als Softwareentwicklerin.

Nach einer Karrierepause wechselte sie ins digitale Marketing und Kampagnenmanagement. Sie arbeitete… Mehr Blogartikel